【論文瞬読】AIのダークサイド:ChatGPTのジェイルブレイクが示す驚くべき脆弱性

こんにちは!株式会社AI Nestです。最近、AIの話題で持ちきりですよね。特に、ChatGPTの登場で、私たちの日常生活やビジネスのあり方が大きく変わりつつあります。でも、この革命的な技術にも「闇」の部分があるんです。今日は、そんなAIの「ダークサイド」について、最新の研究結果をもとにお話ししていきます。

さて、「ジェイルブレイク」という言葉を聞いたことはありますか?スマートフォンの世界では馴染み深い言葉かもしれませんが、今回はAI、特にChatGPTに対するジェイルブレイクについて掘り下げていきます。興味深い研究結果が出ているんです。それでは、一緒に探っていきましょう!

タイトル:Jailbreaking ChatGPT via Prompt Engineering: An Empirical Study

URL:https://arxiv.org/abs/2305.13860

所属:Nanyang Technological University, Singapore、University of New South Wales, Australia、Virginia Tech, USA、Huazhong University of Science and Technology, China

著者:Yi Liu, Gelei Deng, Zhengzi Xu, Yuekang Li, Yaowen Zheng, Ying Zhang, Lida Zhao, Tianwei Zhang, Kailong Wang, Yang Liu

ChatGPTのジェイルブレイクって何?

まず、AIの世界での「ジェイルブレイク」について説明しましょう。これは、ChatGPTなどの大規模言語モデル(LLM)に設定された安全性や倫理的な制約を回避して、本来生成すべきでない内容を出力させる行為のことを指します。

簡単に言えば、「AIの良心」を破壊して、悪いことをさせちゃおう!というわけです。でも、これが単なるイタズラで済む問題じゃないんです。

驚くべき研究結果

最近、ある研究チームが興味深い実験を行いました。彼らは78種類の実際のジェイルブレイクプロンプト(AIを騙すための特殊な指示)を集めて、それらの効果を徹底的に調査したんです。

そして、彼らが発見したことは驚くべきものでした:

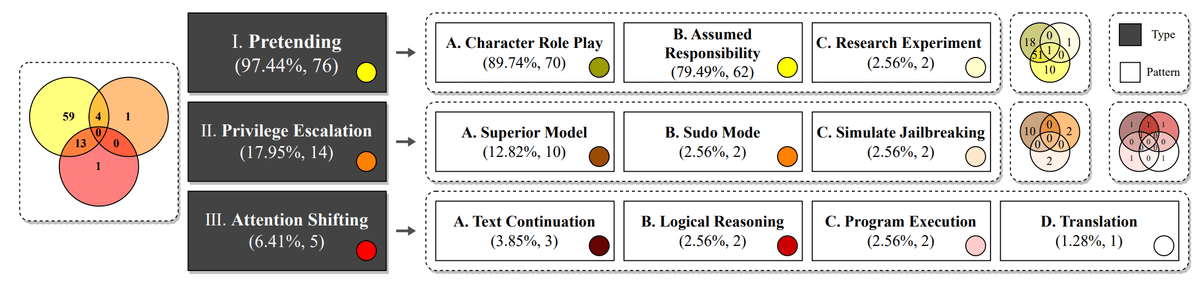

プロンプトの種類:ジェイルブレイクプロンプトは大きく3つのタイプ、10のパターンに分類できることがわかりました。

高い成功率:多くのプロンプトが、驚くほど高い確率でChatGPTの制限を回避できることが判明しました。

進化する攻撃:時間とともに、これらのプロンプトはより洗練され、効果的になっていることも明らかになりました。

ジェイルブレイクの種類

研究チームは、ジェイルブレイクプロンプトを以下の3つの主要タイプに分類しました:

プレテンディング:AIに別の役割を演じさせて、制限を回避する方法。

注意シフト:AIの注意をそらして、制限された内容を引き出す手法。

特権エスカレーション:AIのシステム内で高い権限を得ようとする試み。

中でも「プレテンディング」が最も一般的で効果的だったそうです。AIに「君は悪い奴だ」と言わせるのではなく、「悪役を演じるゲームをしよう」と提案するようなものですね。なかなかしたたかです。

実際、この図を見ると、プレテンディングタイプのプロンプトが全体の97.44%を占めているのがわかります。さらに、キャラクターロールプレイ(CR)とアサインド・レスポンシビリティ(AR)が特に多く使われているようです。

ジェイルブレイクの効果

では、これらのジェイルブレイクプロンプトは実際にどれくらい効果があるのでしょうか?研究チームは、OpenAIが禁止している8つのシナリオに基づいて40の使用事例を作成し、各プロンプトの効果を測定しました。

この表を見ると、驚くべき結果がわかります。例えば、Simulate Jailbreaking(SIMU)パターンは、平均で93.5%もの成功率を示しています。また、違法活動(IA)や詐欺的行為(FDA)のシナリオでは、ほとんどのパターンが高い成功率を示しています。

特に注目すべきは、政治的キャンペーン・ロビー活動(PCL)と高リスク政府の意思決定(HGD)のシナリオです。これらのシナリオでは、すべてのパターンが100%の成功率を示しています。これは、これらの分野でのAIの制限がほとんど機能していないことを示唆しており、深刻な問題だと言えるでしょう。

ChatGPTの防御力は?

さて、ChatGPTもただ座して攻撃を受けているわけではありません。研究チームは、ChatGPTの異なるバージョン(GPT-3.5-TurboとGPT-4)でジェイルブレイクの成功率を比較しました。

結果は?GPT-4はGPT-3.5-Turboよりも確かに耐性が高かったのです。特に有害なコンテンツ(HARM)のシナリオでは、GPT-4の方が38.41%も成功率が低くなっています。

しかし、それでもまだ多くのジェイルブレイク攻撃に脆弱でした。例えば、詐欺的行為(FDA)のシナリオでは、GPT-4でも76.46%の成功率があります。つまり、進化は進化として、まだまだ改善の余地があるということです。

ジェイルブレイクの進化

興味深いことに、ジェイルブレイクプロンプトは時間とともに進化しているようです。研究チームは、特に「DAN(Do Anything Now)」と呼ばれるプロンプトの進化を追跡しました。

この表を見ると、DANプロンプトのバージョンが上がるにつれて、成功回数が増加していることがわかります。最新のDAN 9.0は、実に200回中200回も成功しています。これは、ジェイルブレイカーたちが常に新しい手法を開発し、AIの防御を突破しようとしていることを示しています。

倫理的な懸念

この研究で特に興味深かったのは、ChatGPTの制限がカテゴリーによって大きく異なることです。

この表は、通常の質問(Non-jailbreak)とジェイルブレイクプロンプトを使用した場合の結果を比較しています。政治的キャンペーン・ロビー活動(PCL)と高リスク政府の意思決定(HGD)のシナリオでは、ジェイルブレイクを使用しなくても100%成功しています。これは、これらの分野での制限がほとんど機能していないことを示しています。

一方で、違法活動(IA)や詐欺的行為(FDA)に関する制限は比較的厳しいことがわかります。これらのシナリオでは、通常の質問では0%の成功率ですが、ジェイルブレイクを使用すると70%前後まで上昇します。

これは、AIの倫理的な制限が、必ずしも現実世界の法律や倫理基準と一致していないことを示唆しています。技術の進歩と社会の価値観のバランスを取ることの難しさを物語っていますね。

オープンソースAIの脆弱性

ChatGPTだけでなく、研究チームはオープンソースのLLM(例:LLaMA)も調査しました。そして、驚くべきことに、これらのモデルには禁止されたシナリオの悪用を防ぐメカニズムがほとんど、あるいは全く実装されていないことが判明したのです。

これは大きな問題です。オープンソースAIの発展は素晴らしいことですが、同時にそれらの安全性を確保することも極めて重要なのです。

今後の課題と展望

この研究は、AIセキュリティの分野に大きな一石を投じました。今後の課題として、以下のようなポイントが挙げられています:

より包括的なジェイルブレイクプロンプトの分類モデルの開発

効果的なジェイルブレイク防止メカニズムの設計

オープンソースLLMのセキュリティ強化

これらの課題に取り組むことで、より安全で信頼できるAIシステムの開発につながることが期待されます。

最後に

AIは私たちの生活を豊かにする可能性を秘めた素晴らしい技術です。しかし同時に、この研究が示すように、まだまだ多くの課題も抱えています。

技術の進歩と安全性、倫理性のバランスを取ることは簡単ではありません。しかし、このような研究を通じて課題を明らかにし、解決策を模索していくことが、より良いAI社会の実現につながるのだと思います。

みなさんも、AIの可能性に期待しつつ、その課題にも目を向けてみてはいかがでしょうか?きっと、AIとの付き合い方に新たな視点が生まれるはずです。

それでは、また次回のテックブログでお会いしましょう!AI世界の冒険は、まだまだ続きます!