【論文瞬読】UI-TARS: AIエージェントによるGUI操作の自動化とその進化

はじめに

こんにちは!株式会社AI Nestです。近年、AI技術の進化によって、様々なタスクを自動化できるようになってきました。その中でも、 GUI (Graphical User Interface) の操作を自動化する GUIエージェント は、私たちのワークフローを劇的に変える可能性を秘めています。

GUIエージェントとは、人間とコンピュータ間のインタラクションを円滑にするために設計されたAIエージェントです。 例えば、Webサイトの閲覧、アプリケーションの操作、OSの設定変更など、GUIを介して行う様々なタスクを自動化することができます。

しかし、従来のGUIエージェントは、その能力に限界がありました。 本記事では、これらの限界を克服し、GUI操作の自動化を新たなレベルへと引き上げるネイティブGUIエージェントモデル 「UI-TARS」 について解説します。 UI-TARSは、スクリーンショットのみを入力として認識し、キーボードやマウス操作などの人間のようなインタラクションを実行することができます。

タイトル: UI-TARS: Pioneering Automated GUI Interaction with Native Agents

URL: https://arxiv.org/abs/2501.12326

所属: ByteDance Seed, Tsinghua University

著者: Yujia Qin, Yining Ye, Junjie Fang, Haoming Wang, Shihao Liang, Shizuo Tian, Junda Zhang, Jiahao Li, Yunxin Li, Shijue Huang, Wanjun Zhong, Kuanye Li, Jiale Yang, Yu Miao, Woyu Lin, Longxiang Liu, Xu Jiang, Qianli Ma, Jingyu Li, Xiaojun Xiao, Kai Cai, Chuang Li, Yaowei Zheng, Chaolin Jin, Chen Li, Xiao Zhou, Minchao Wang, Haoli Chen, Zhaojian Li, Haihua Yang, Haifeng Liu, Feng Lin, Tao Peng, Xin Liu, Guang Shi

UI-TARSは、従来のエージェントフレームワークとは異なり、エンドツーエンドで学習されるため、より効率的かつ正確なGUI操作を実現します。 本記事では、UI-TARSのアーキテクチャ、コア機能、および主要な技術革新について詳しく解説するとともに、その性能評価結果を紹介します。

GUIエージェントとは?

GUIエージェントは、 人間とコンピュータ間のインタラクションを円滑にする ために設計されたAIエージェントです。 人間がGUIを介して行う様々なタスクを自動化することができます。 GUIエージェントの役割は、単純な自動化から、人間のワークフローと統合し、タスク実行プロセスにおいて ツールとしてだけでなく、共同作業者として 行動する、自己改善型のフルエージェントへと移行しています。

GUIエージェントは、 ワークフローの自動化 において特に重要です。 反復的なタスクの効率化、人為的ミスの削減、生産性の向上に役立ちます。 例えば、次のようなタスクを自動化することができます。

Webサイトでの情報収集

オンラインショッピングでの購入手続き

アプリケーションのインストールと設定

OSのアップデート

ファイルの整理

定型的なメール送信

GUIエージェントの進化は、 人間の介入の度合いと汎化能力 に基づいて、いくつかの主要な段階に分けられます。

従来のGUIエージェントの課題

従来のGUIエージェントは、主に ルールベース のシステムでした。 これらのシステムは、予め定義されたルールに従って動作するため、 柔軟性に欠ける という問題がありました。 また、 新しいタスクや環境の変化に対応 するためには、人間がルールを書き換える必要があり、 保守が困難 でした。

さらに、従来のGUIエージェントは、 HTML構造やアクセシビリティツリー などのテキスト表現に依存していました。 これらの手法は、 プラットフォーム固有の不整合性、冗長性、スケーラビリティの制限 などの問題を抱えていました。

UI-TARS: ネイティブGUIエージェントモデル

UI-TARSは、これらの課題を克服するために開発された ネイティブGUIエージェントモデル です。 UI-TARSは、 スクリーンショットのみを入力 として認識し、 キーボードやマウス操作 などの人間のようなインタラクションを実行することができます。 従来のエージェントフレームワークとは異なり、 エンドツーエンドで学習 されるため、より効率的かつ正確なGUI操作を実現します。

アーキテクチャ

UI-TARSは、 知覚、行動、推論、記憶 という4つのコア機能を統合したモデルです。

知覚: GUIのスクリーンショットを認識し、その内容を理解する機能です。

行動: キーボードやマウスなどの入力デバイスを操作する機能です。

推論: タスクを達成するために行動を計画する機能です。

記憶: 過去の経験や知識を記憶し、行動計画に役立てる機能です。

これらの機能は、 単一のモデルに統合 されているため、UI-TARSは、GUI操作における様々なタスクを効率的に実行することができます。

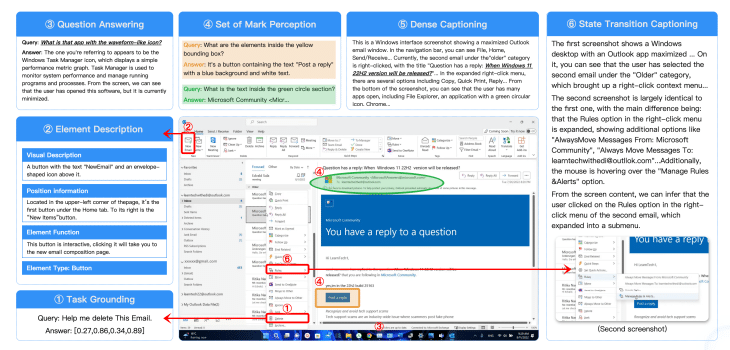

強化された知覚

UI-TARSは、 GUIのスクリーンショット から、要素の種類、深度、境界ボックス、テキストコンテンツなどの メタデータを自動的に抽出 することで、GUIの要素を正確に認識し、理解することができます。

UI-TARSは、この強化された知覚能力により、 高情報密度で複雑なレイアウトのGUI でも、正確に操作することができます。

統一された行動モデリング

UI-TARSは、 プラットフォーム間で意味的に等価な行動 を標準化する共通の行動空間を設計しています。 例えば、Windowsでの「クリック」とモバイルでの「タップ」は、どちらも同じ「クリック」という行動として扱われます。 これにより、UI-TARSは、 異なるプラットフォーム間 での知識転移を効率的に行うことができます。

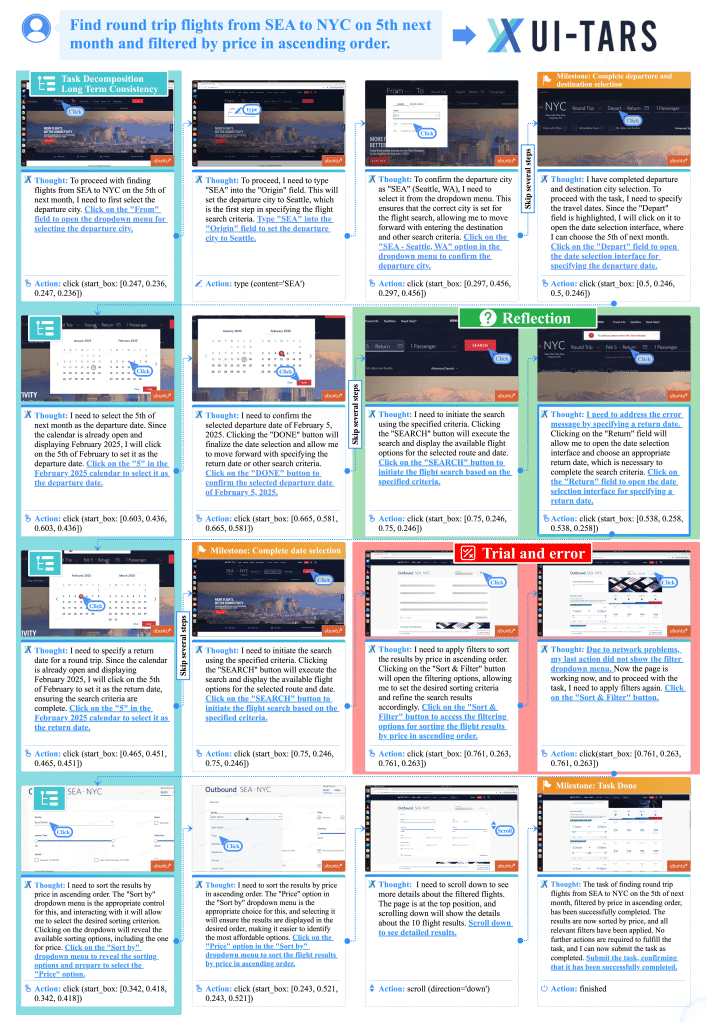

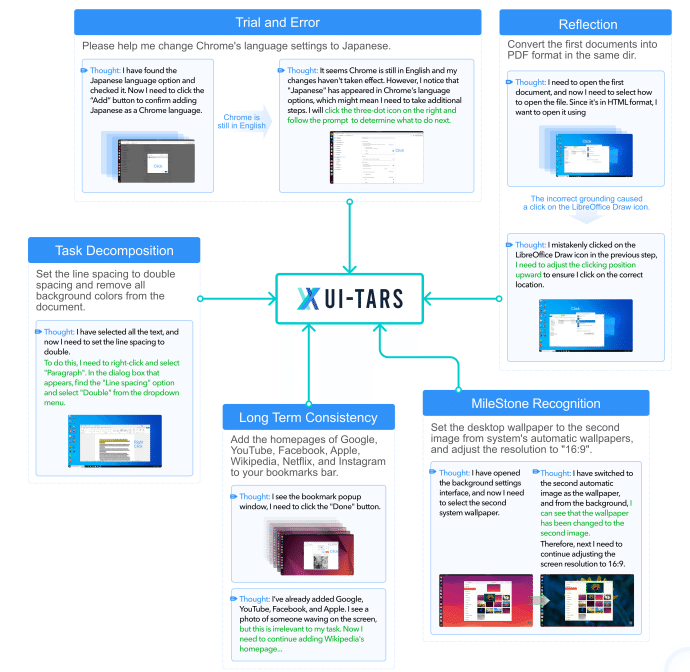

システム2推論

UI-TARSは、 システム2推論 と呼ばれる、人間の 熟考的な思考プロセス を模倣した推論機能を備えています。 システム2推論は、タスク分解、長期的な一貫性、マイルストーン認識、試行錯誤、反省などの様々な推論パターンを組み合わせて、 複雑なタスク にも対応することができます。

UI-TARSは、このシステム2推論により、 動的な環境 においても、 柔軟かつ正確 にタスクを実行することができます。

経験からの学習

UI-TARSは、 オンラインブートストラップ と呼ばれる手法を用いて、 実際のデバイスとのインタラクション から学習し、 継続的に自己改善 することができます。

UI-TARSは、この学習能力により、 新しいタスクや環境の変化 にも、 柔軟に対応 することができます。

UI-TARSの性能評価

UI-TARSの性能は、 知覚、グラウンディング、エージェント という3つの側面から評価されました。

知覚能力

UI-TARSの知覚能力は、Visual-WebBench、WebSRC、ScreenQA-shortなどのベンチマークを用いて評価されました。

Visual-WebBench: Webページの理解度とグラウンディング能力を測定します。

WebSRC: Webページの構造理解度を測定します。

ScreenQA-short: モバイル画面のコンテンツ理解度を測定します。

UI-TARSは、これらのベンチマークにおいて、 SOTA の性能を達成しました。

グラウンディング能力

UI-TARSのグラウンディング能力は、ScreenSpot Pro、ScreenSpot、ScreenSpot v2などのベンチマークを用いて評価されました。

ScreenSpot Pro: 高解像度の専門的な環境におけるグラウンディング能力を測定します。

ScreenSpot: モバイル、デスクトップ、WebプラットフォームにおけるGUIグラウンディングをテストします。

ScreenSpot v2: ScreenSpotの注釈エラーを修正したバージョンです。

UI-TARSは、これらのベンチマークにおいても、 SOTA の性能を達成しました。

エージェント能力

UI-TARSのエージェント能力は、Multimodal Mind2Web、Android Control、GUI Odysseyなどのベンチマークを用いて評価されました。

Multimodal Mind2Web: Webエージェントの言語指示実行能力を評価します。

Android Control: モバイル環境における計画および行動実行能力を評価します。

GUI Odyssey: モバイル環境におけるクロスアプリナビゲーションタスクに焦点を当てています。

UI-TARSは、これらのベンチマークにおいても、 SOTA の性能を達成しました。 特に、 OSWorld ベンチマークでは、UI-TARSは 50ステップで24.6、15ステップで22.7 のスコアを達成し、 Claudeの22.0と14.9をそれぞれ上回りました 。 また、 AndroidWorld では、UI-TARSは 46.6 を達成し、 GPT-40の34.5を上回りました 。

システム1とシステム2の推論の比較

UI-TARSは、システム1とシステム2の 両方の推論能力 を備えています。 システム1は、 直感的 な意思決定を行うのに対し、システム2は、 より熟考的な思考プロセス を行います。

ドメイン内ベンチマークでは、 システム1 の方が わずかに優れて いましたが、ドメイン外ベンチマークでは、 システム2 の方が 優れて いました。 これは、システム2の 深い推論能力 が、 未知のタスク に対する汎化に役立つことを示唆しています。

まとめ

本記事では、ネイティブGUIエージェントモデル 「UI-TARS」 について解説しました。 UI-TARSは、 スクリーンショットのみを入力 として認識し、 キーボードやマウス操作 などの人間のようなインタラクションを実行することができます。 従来のエージェントフレームワークとは異なり、 エンドツーエンドで学習 されるため、より効率的かつ正確なGUI操作を実現します。

UI-TARSは、 強化された知覚、統一された行動モデリング、システム2推論、経験からの学習 などの革新的な技術により、GUI操作の自動化を新たなレベルへと引き上げます。 私たちは、UI-TARSが、 様々な分野 でのワークフローの自動化に貢献し、 人々の生活をより豊かにする と信じています。

今後の展望 として、UI-TARSを より大規模なデータセットで学習 することで、 さらに複雑なタスク にも対応できるように改良していく予定です。 また、 ユーザーのフィードバック を取り入れながら、 より使いやすく、より実用的な モデルへと進化させていきたいと考えています。