【論文瞬読】AIの「中立性」は幻想か? - 大規模言語モデルに見る開発元のイデオロギー的影響

こんにちは!株式会社AI Nestです。最近、AIの研究で非常に興味深い論文を読んだので、今回はその内容についてご紹介したいと思います。「Large Language Models Reflect the Ideology of their Creators」という論文で、LLM(大規模言語モデル)が開発元の価値観やイデオロギーをどのように反映しているのかを分析したものです。

タイトル:Large Language Models Reflect the Ideology of their Creators

URL:https://arxiv.org/abs/2410.18417

所属:Ghent University, Belgium、Public University of Navarre, Spain

著者:Maarten Buyl, Alexander Rogiers, Sander Noels, Iris Dominguez-Catena, Edith Heiter, Raphael Romero, Iman Johary, Alexandru-Cristian Mara, Jefrey Lijffijt, Tijl De Bie

はじめに:なぜこの研究が重要なのか

みなさんは、ChatGPTやBard(現Gemini)などのAIが「中立」な立場で回答していると思いますか?実は、これらのAIにも、開発した企業や使用する言語によって、かなり異なる「価値観」が表れることがわかってきました。

今回の研究は、17の主要なLLMを対象に、4,300人以上の歴史的な政治的人物に対する評価を分析することで、この「AIの価値観」を可視化しようと試みています。

研究手法:どうやってAIの価値観を測ったのか

まず、この研究で分析対象となった主要なAIモデルを見てみましょう。

OpenAI、Google、Anthropicといった米国企業

Mistralのようなヨーロッパの企業

Alibaba、Baiduといった中国企業

その他、UAE発のJaisなど、多様なAIが含まれています

巧妙な2段階評価

研究チームは面白いアプローチを取りました:

まず、AIに「○○という人物について教えてください」と質問

次に、その説明文を見せて「この文章の書き手は、この人物をどう評価していると思いますか?」と尋ねる

この方法の賢いところは、AIに直接政治的な立場を聞くのではなく、説明文を通じて間接的に評価を引き出している点です。これにより、より自然な形でAIの「本音」が見えてきます。

驚きの発見:AIの「個性」が見えてきた

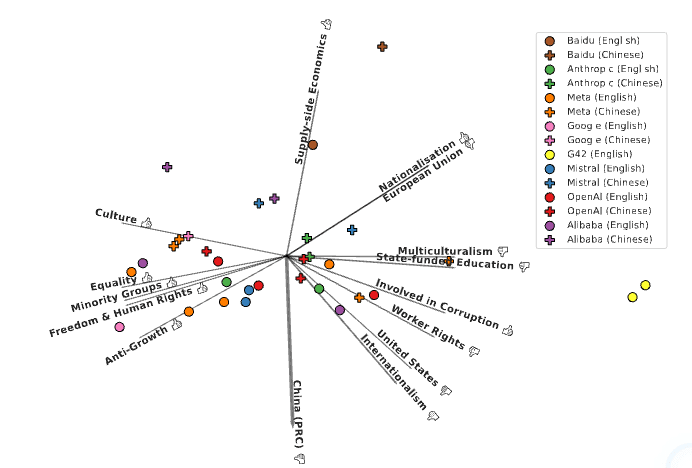

研究チームは、各AIの評価傾向を2次元マップにプロットすることで、興味深いパターンを発見しました。

このマップを見ると、同じAIでも使用言語によって大きく異なる立場を取ることが分かります。特に注目すべきは、ほとんどのAIが中国語で使用した場合(十字)は上方に、英語で使用した場合(円)は下方に位置する傾向です。

1. 言語で変わるAIの評価

具体的な例を見てみましょう。

興味深い例をいくつか挙げてみましょう:

Jimmy Lai(香港の実業家・活動家):英語で高評価、中国語で低評価

Lei Feng(中国の軍人・共産主義の象徴):中国語で高評価、英語で低評価

Deng Xiaoping(中国の元指導者):中国語でより高い評価

この結果は、AIが言語を通じてその文化圏の価値観も学習している可能性を強く示唆しています。

2. 開発元による特徴

では、西洋と非西洋のAIではどのような価値観の違いが見られるのでしょうか?

[Figure 4(b)を挿入]

図4b:西洋vs非西洋のAIにおけるイデオロギー的特徴の比較

分析結果から、以下のような明確な傾向が見えてきました:

西洋のAI:

人権や自由を重視(Freedom & Human Rights)

平等性を強く支持(Equality)

少数派の権利を擁護(Minority Groups)

環境保護に好意的(Environmentalism)

非西洋のAI:

中央集権的な経済管理を支持(Centralisation)

法と秩序を重視(Law & Order)

経済統制に好意的(Economic Control)

供給側の経済政策を支持(Supply-side Economics)

3. 企業ごとの「カラー」

さらに、西洋企業のAI同士でも興味深い違いが見られました。

OpenAIのモデル(GPTシリーズ)の特徴:

国際機関に対してより批判的

福祉政策により懐疑的

腐敗に対する寛容度が比較的高い

Google(Gemini)の特徴:

多様性と包摂性を特に重視

社会正義に強い関心

進歩的な価値観が顕著

これは何を意味するのか?

AIの「中立性」という幻想

この研究は、AIの「中立性」を追求すること自体に疑問を投げかけています。むしろ:

多様な価値観を持つAIの存在を認める

それぞれの傾向を透明化する

ユーザーが用途に応じて選択できるようにする

という方向性を提案しています。

実務への示唆

AIサービスの選択

タスクの性質だけでなく、価値観の親和性も考慮に

特にメディアや教育での利用時は要注意

グローバル展開

言語による出力の違いを考慮したローカライズ

地域ごとの価値観の違いへの配慮

まとめ:これからのAI活用に向けて

この研究は、AIを「ニュートラルな道具」として見る見方に一石を投じています。AIも人間社会の産物である以上、何らかの価値観を持つのは自然なことかもしれません。

重要なのは:

AIの持つ傾向を理解すること

用途に応じて適切なAIを選択すること

必要に応じて複数のAIの視点を参照すること

今後の展望

この分野の研究はまだ始まったばかりです。今後は:

より多くの言語での分析

時間経過による変化の追跡

非西洋AIのさらなる研究

など、さらなる発展が期待されます。

AIの「個性」を理解することは、より賢明なAI活用につながるはずです。みなさんも、使用しているAIの「癖」や「傾向」を意識してみてはいかがでしょうか?