【論文瞬読】AIの「言い訳」を科学する- Verbosity Compensation現象から見えてきた、最新LLMの興味深い性質

こんにちは!株式会社AI Nestです。今回は、Penn State Universityの研究チームによる革新的な論文「VERBOSITY ≠ VERACITY」をご紹介します。AIが不確かな回答をするとき、人間のように言葉数が増えてしまう...そんな興味深い現象について、実践的な観点を交えながら詳しく見ていきましょう!

タイトル:Verbosity ≠ Veracity: Demystify Verbosity Compensation Behavior of Large Language Models

URL:https://arxiv.org/abs/2411.07858

所属:Department of Computer Science and Engineering, Penn State University

著者:Yusen Zhang, Sarkar Snigdha Sarathi Das, Rui Zhang

1. 研究の背景:なぜAIは「おしゃべり」になるのか?

ChatGPTなどのAIに質問したとき、簡単な質問なのに異常に長い回答が返ってきた経験はありませんか?実は、これには深い理由があったのです。

・簡潔な回答(高性能、低不確実性)

・質問を繰り返す冗長な回答(低性能、高不確実性)

・曖昧さを含む冗長な回答(低性能、高不確実性)

研究チームは、この現象を「Verbosity Compensation(VC)」と名付けました。これは、「簡潔に回答するよう指示されたにもかかわらず、情報損失なく圧縮可能な応答を生成する行動」と定義されています。

特に興味深いのは、この振る舞いが人間の行動とよく似ているという点です。私たちも自信がないとき、つい説明が長くなったり、同じ内容を別の言い方で繰り返したりしますよね。AIも同じような行動パターンを示すのです。

2. 驚きの研究結果:数字が語る実態

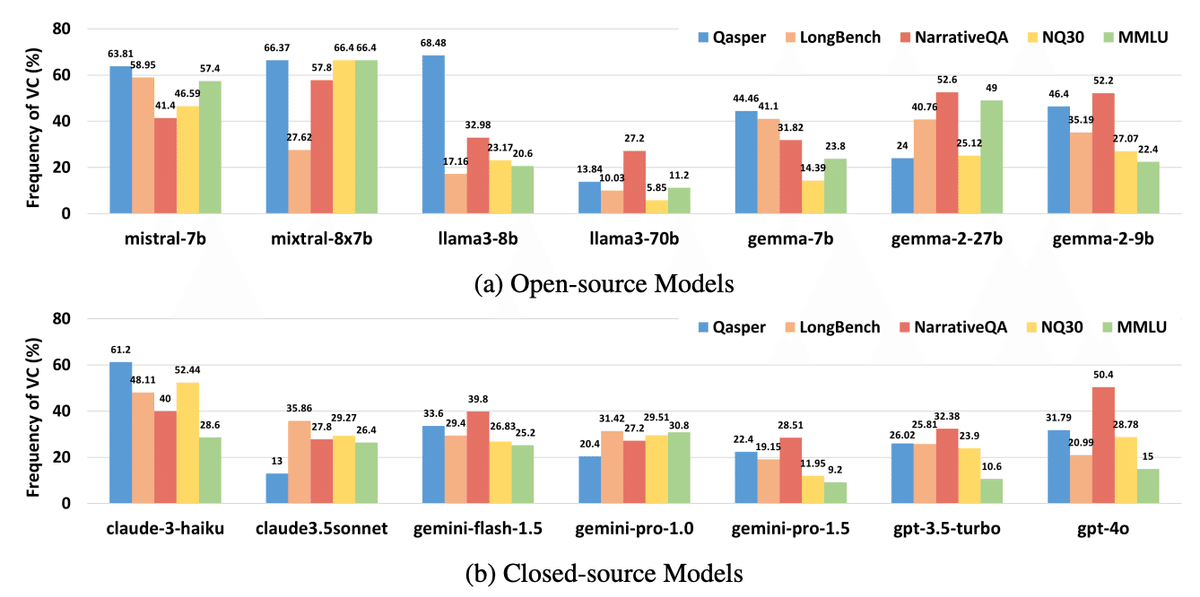

研究チームが14個の最新LLMを分析した結果は、衝撃的なものでした。最新のGPT-4でさえ、50.40%という高い確率でVC現象が発生することが判明しました。さらに注目すべきは、冗長な応答では最大27.61%もの精度低下が観察されたことです。

より高性能なモデルを使用しても、この問題は自然には解決されないことも分かりました。これは、AIの進化だけでは解決できない本質的な課題であることを示唆しています。

3. 実務への影響:コストと品質のジレンマ

この「おしゃべり」な性質は、ビジネスにおいて見過ごせない影響をもたらします。まず、APIコストの増加という直接的な問題があります。また、重要な情報が冗長な説明に埋もれてしまい、ユーザーの理解を妨げる可能性もあります。

しかし、研究チームは興味深い解決策も提案しています。複数のモデルを組み合わせる「カスケードアルゴリズム」です。これは、まず軽量なモデルで回答を試み、必要に応じて高性能なモデルを使用するという方法です。この手法により、VCの発生率を大幅に削減できることが実証されました。

4. 実践的な活用のために:効果的なプロンプト設計

AIとの効果的なコミュニケーションには、適切なプロンプト設計が重要です。例えば、「3文以内で要点のみ答えてください」といった明確な指示は、冗長な応答を防ぐ効果があります。また、応答に質問の繰り返しや曖昧な表現が多用されている場合は、モデルが不確実性を抱えているサインかもしれません。

4つのモデル(mistral-7b, mixtral-8x7B, llama-3-8b, gpt-turbo-3.5)において

・応答の長さが増えるほど不確実性が上昇

・特に3トークン以上で急激な不確実性の増加

5. 今後の展望:進化する研究分野

この研究分野には、まだ多くの課題が残されています。VCのメカニズムの理論的解明や、より効率的な検出方法の開発などが期待されます。特に注目すべきは、マルチモーダルモデルにおけるVC現象の研究です。画像や音声を含む応答でも同様の現象が観察されるのか、今後の研究が待たれます。

6. まとめ:AIとの付き合い方を考える

AIの「おしゃべり」な性質は、必ずしもネガティブな特徴ではありません。むしろ、それはAIの不確実性を示す重要なシグナルとして活用できる可能性があります。適切な理解と対策により、よりスマートなAI活用が可能になるでしょう。

今回の論文を読んで、AIの興味深い性質について、新しい発見があったのではないでしょうか。今後もAIの進化をウォッチしていこうと思います!