[ComfyMaster55] Google Colabでは何を選べばいい?いくらかかる?どれを使う?2025年3月版

動画生成「Wan2.1」のリリースにより、動画生成を自分自身のワークフローで動作させることも現実的になってきました。

この記事では来たるべき動画生成AI時代に向けて、基本に立ち返り、最先端のComfyUIを使うことで、必要となる演算環境とコストについて分析してみました。

そもそもGoogle Colabは何を選べばいいの?

これまでAICUでは様々なケースでGoogle Colabを紹介してきました。

動画生成が自分のホストできる時代がやってきたとして、どのようなプランを契約し、どのランタイムを選べばよいのでしょうか?

最近更新されたGoogle Colabのラインナップとコストを調査してみました。

VRAM最強はA100、メモリ最強は…?

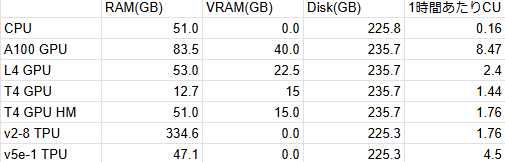

こちらが2025年2月末時点でのGoogle Colab Proで利用できる環境の一覧です。

RAM(GB) VRAM(GB) Disk(GB) 1時間あたりCU消費

CPU 51.0 0.0 225.8 0.16

A100 GPU 83.5 40.0 235.7 8.47

L4 GPU 53.0 22.5 235.7 2.4

T4 GPU 12.7 15 235.7 1.44

T4 GPU HM 51.0 15.0 235.7 1.76

v2-8 TPU 334.6 0.0 225.3 1.76

v5e-1 TPU 47.1 0.0 225.3 4.5

Google Colabでいちばんお安く利用できるGPU搭載環境はT4 GPUです。

画像生成AIを使用するなら、まずT4GPU(通常メモリ)で実験してみましょう(GPUがないと、とても時間がかかります!)。

また「T4 ハイメモリ」はメインメモリ、つまりRAMが51GBになるだけでVRAMは増えません。一方でメインメモリが欲しいだけであれば、v2-8 TPUが334.6GBも利用できます。

画像生成AIやLLMはオンボードのオンメモリにダウロードしたcheckpointが「乗り切った状態」が最も高速です。つまり6GBほどの重み(wights, checkpointファイル) が乗り切るには最低でも6GBほしい、ということになります。複数のcheckpointを使わなければならないときやノートPCのように最大VRAMが小さい場合は、メインメモリに分散して利用することになります(自動で処理されます)。

VRAMが使えるGPUの中ではA100の40GBが最強です。

料金は、1時間あたり8.47CUを消費します。

Google Colabの料金はComputing Unit (CU)で表現され、動的に変わります。

料金的には100CUで1179円なので、1時間あたり99.9円。T4の5-6倍の値段です。ただし、インストールをしたりダウンロードをしている時間もCUを消費しますので、まずは実験をするのであればL4の20GBや、T4の15GBを使って試してみるのががよいでしょう。

実際のVRAM消費、コストと体感速度。

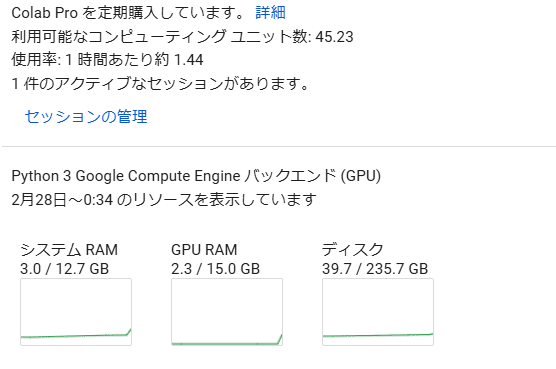

ではGoogle Colab Proで様々な環境を使って、実験をしてみます。

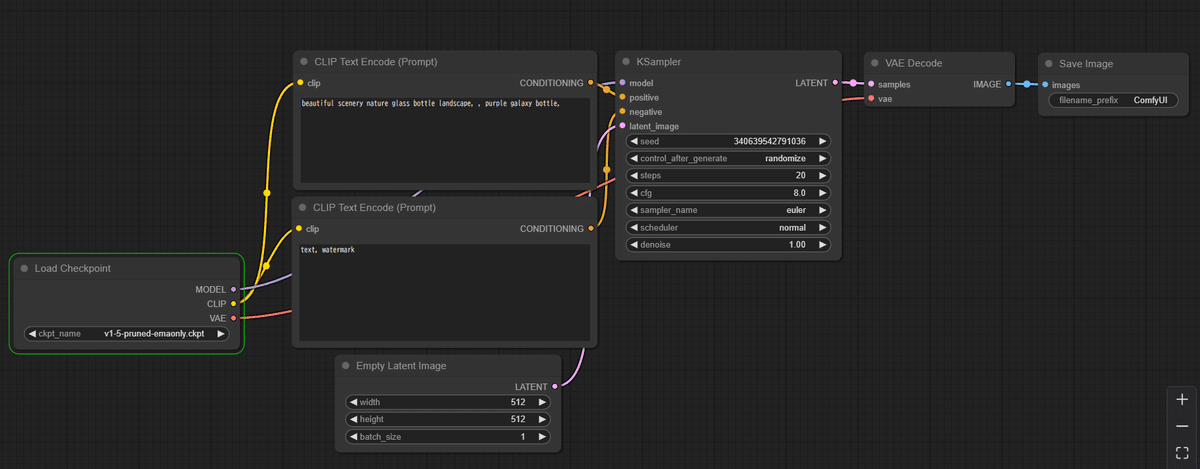

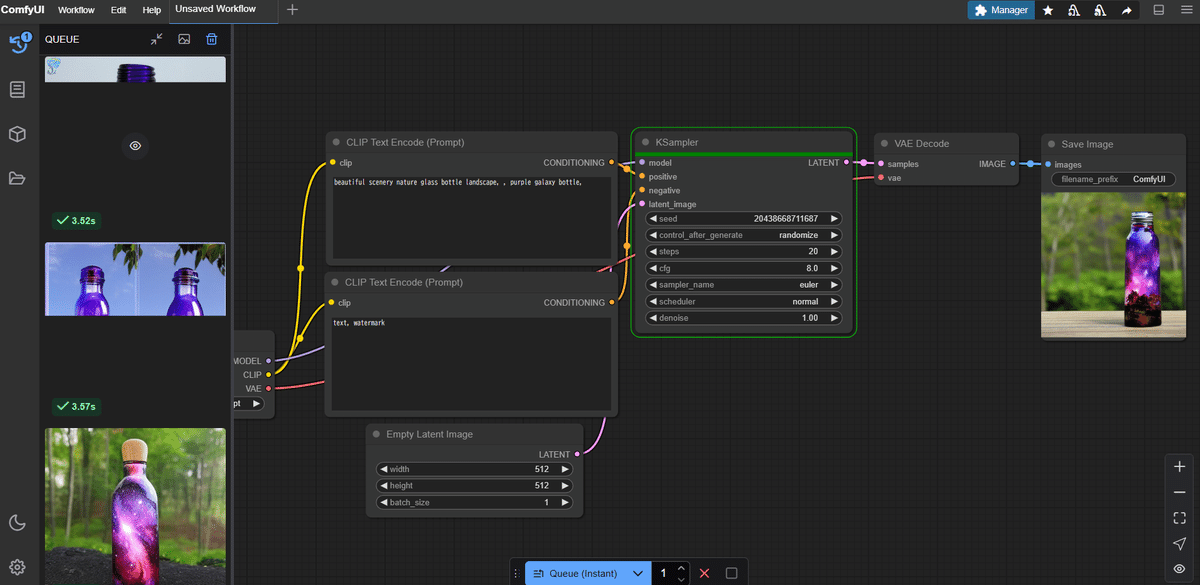

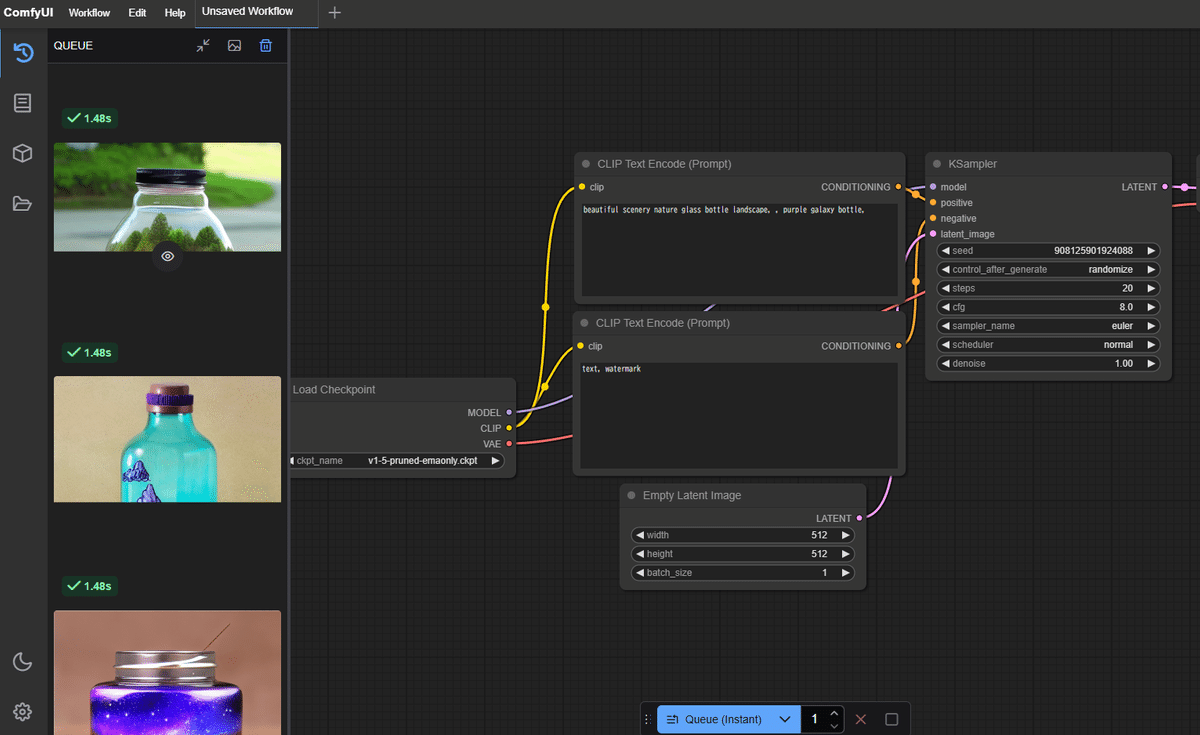

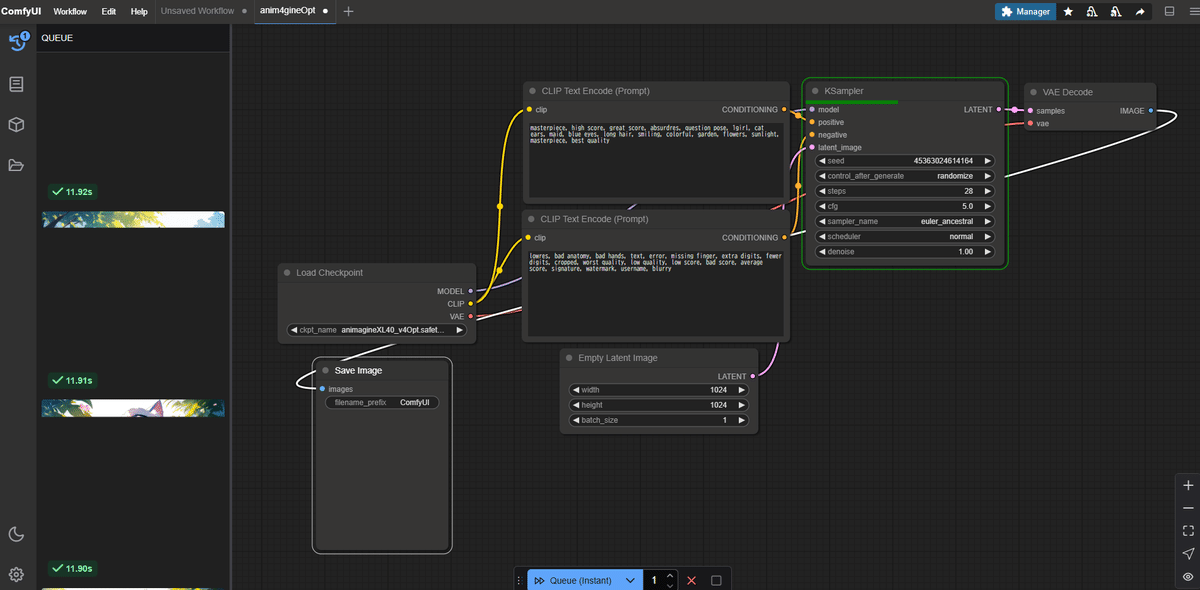

ComfyUIにStable Diffusion 1.5をロードして、画像を生成する基本のワークフローです。

まずは一番安価なT4 GPUを使ってみます。

コストは1.44CU、1時間あたり17円、24時間で407円です。仮に1ヶ月使い続けたとして12,223円です。

連続画像生成をさせてみます。

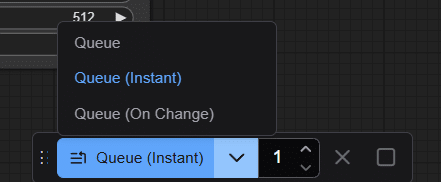

Queueボタンは通常は「1枚生成」ですが「🔻」を押して「Queue (Instant)」を選んで生成すると連続生成になります。

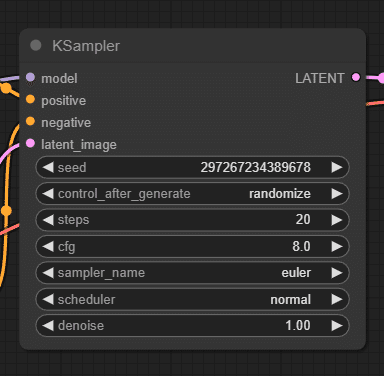

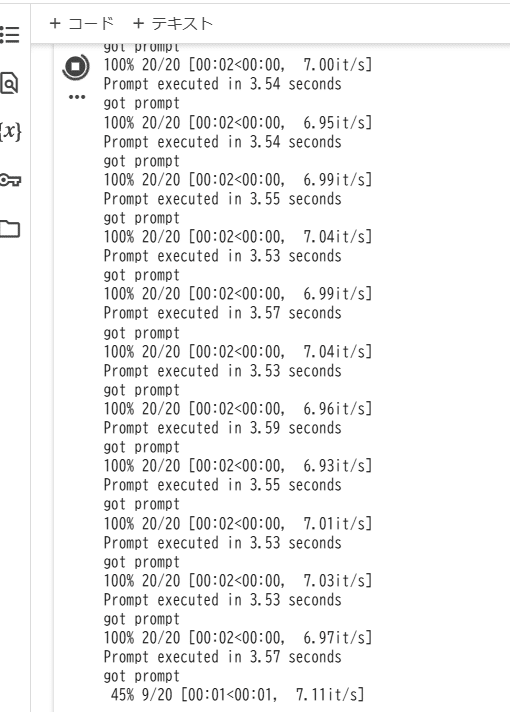

デフォルトの20ステップ、euler、512x512のLatent Imageであれば1画像生成あたり3.7秒ぐらいです。

1秒あたり7イテレーション、20ステップなので3秒ぐらい、という計算になります。

Google Colab L4 GPUでの体感速度

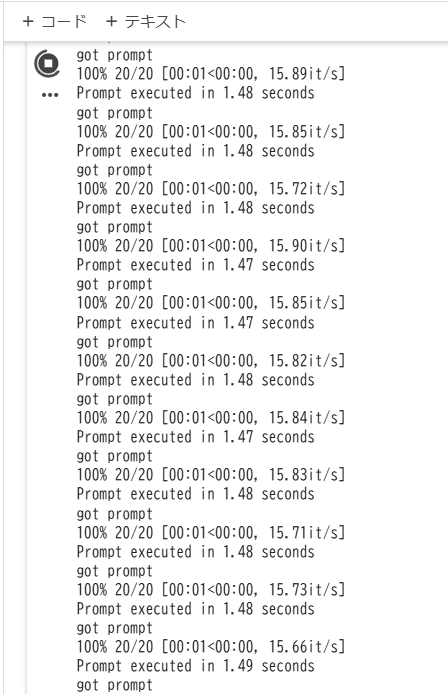

同じスクリプトを T4ではなく L4 GPUに変更して実行してみます。

コストは1.44CU→2.4CU、1時間あたり17円→28円、24時間で407円→679円です。仮に1ヶ月30日使い続けたとして12,223円→20,373円です。

先述のデフォルトワークフロー、SD1.5での画像生成は以下のとおりです。

1.47秒/生成、15.89イテレーション/秒。ちょうどT4はL4の倍ぐらいの性能があるということになります。

Animagine XL 4 Optを使った実験

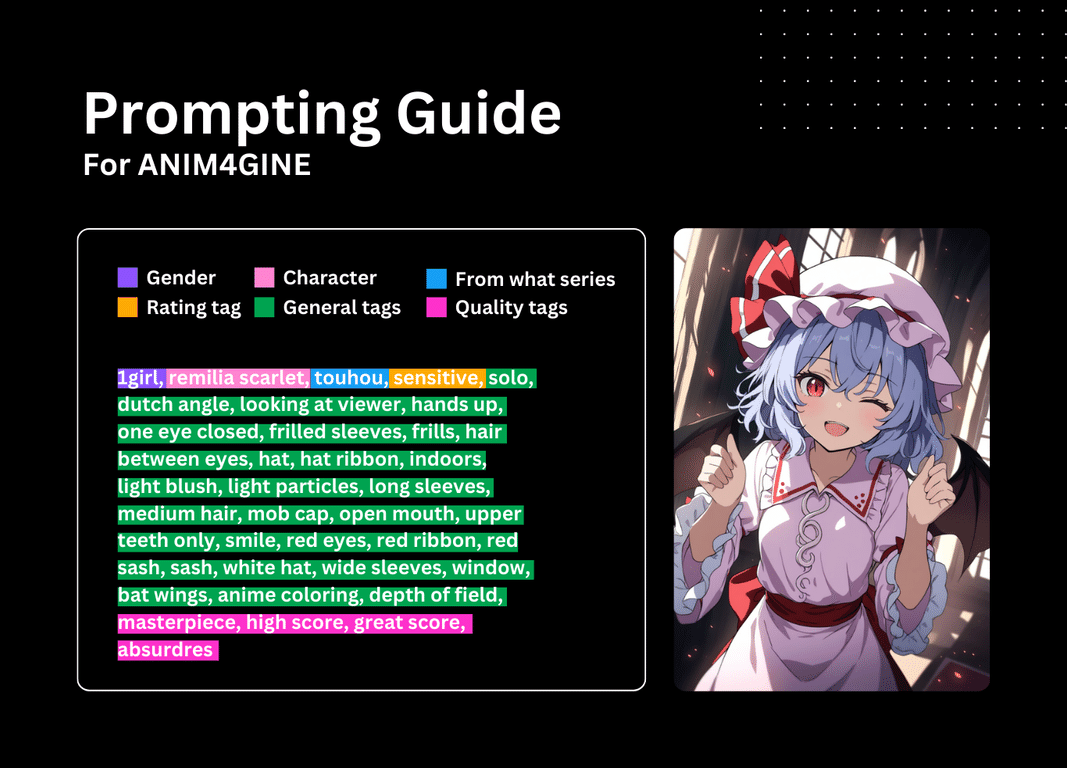

さて、より実用的な画像生成として「Animagine XL 4 Opt」を使ってみましょう。

公式の設定やプロンプトガイドに従ってプロンプトを構築するの忘れずに。

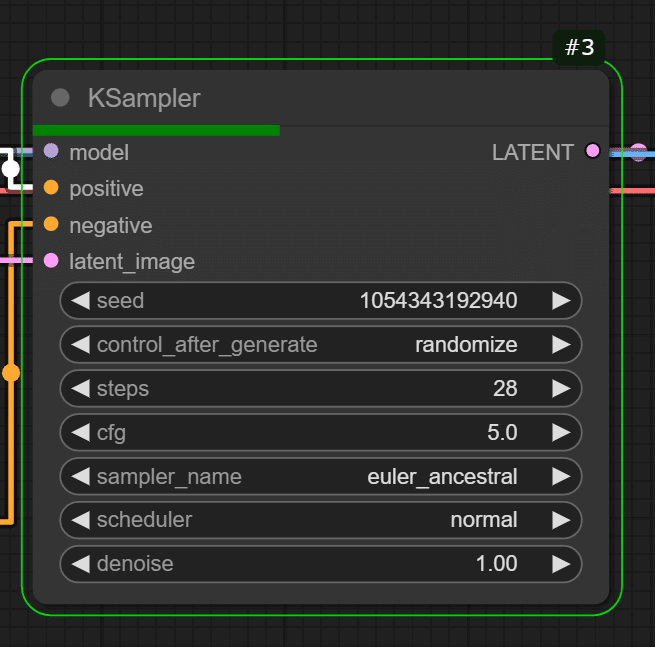

ステップを28、CFGを5.0、サンプラーを「euler_ancestral」にします。

生成画像は素晴らしいです…!

Animagine XL 4 Opt - Google Colab L4 GPU での 速度は?

11.9sec、2.51it/sという結果でした。

Google Colab環境は、Googleのクラウドをトンネリングをして利用しているためか、画像の転送のほうが重たい印象があります。ダウンロード自体は高速ですが、(ドライブに保存されたモデルを使わずに)毎回、クリーンインストールする場合は必要なモデルをダウンロードしていると結構な時間がかかってしまいます。一方で生成した画像をGoogle Driveに直接保存できるといった利点もあります。時間限定とはいえ、使いやすいPythonノートブック環境と非常に安価にGPU演算環境を占有できる点が魅力です。

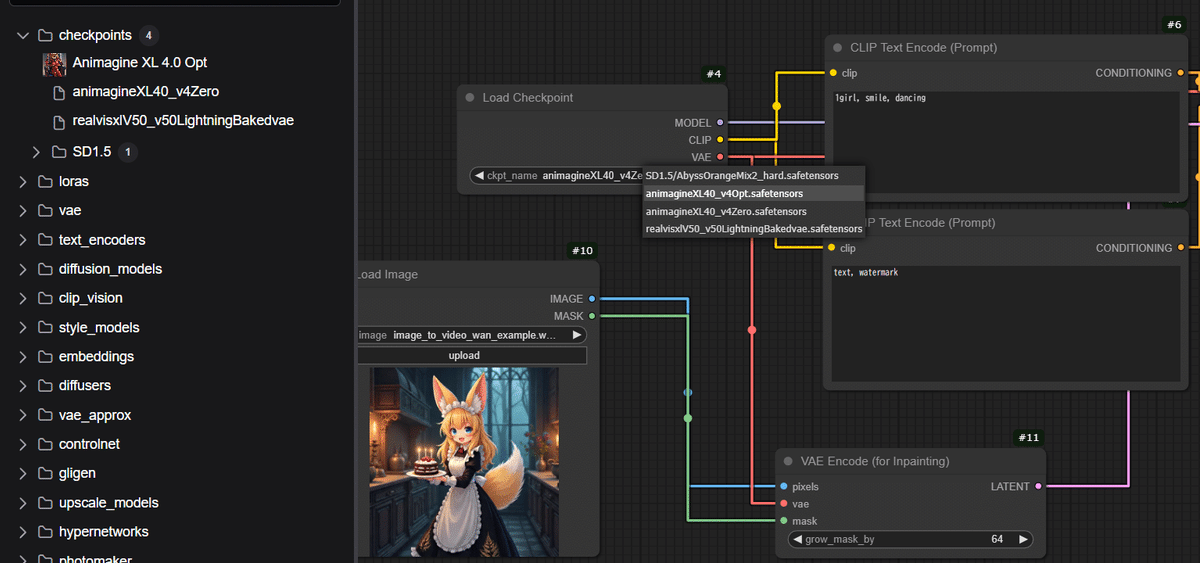

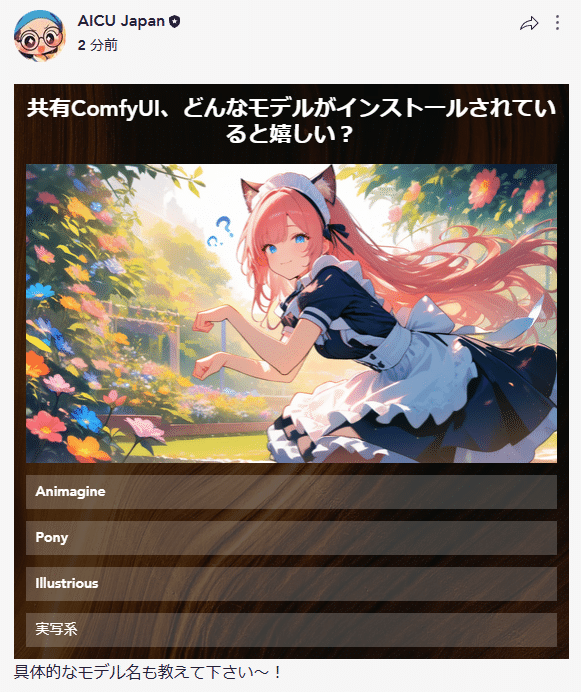

もちろん、あまり難しいことを考えずにすぐ試してみたい!という場合はAICU(アイキュー)が運営する「共有ComfyUI」もオススメです。

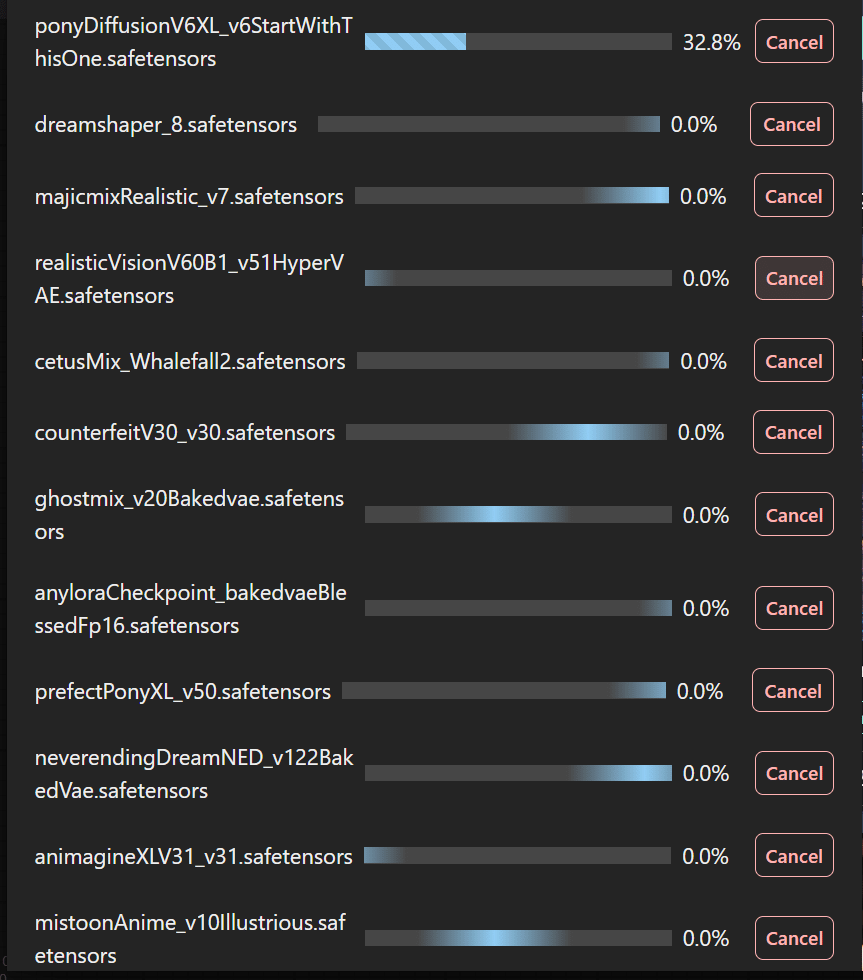

モデルのインストールも一時的に開放しています。Animagine XL 4の更新版「Animagine XL 4.0 Opt」と「Animagine XL 4.0 Zero」も利用できます。

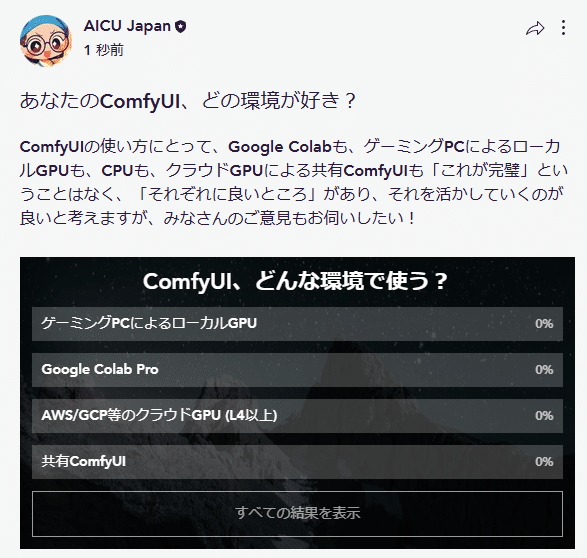

ComfyUIの使い方にとって、Google Colabも、ゲーミングPCによるローカルGPUも、CPUも、クラウドGPUによる共有ComfyUIも「これが完璧」ということはなく、「それぞれに良いところ」があり、それを活かしていくのが良いと考えます。

AICUはオープンソースでの画像生成AIに長く参加してきたので、その本質を理解しています。多様なケースの利点について、皆さんの知見がありましたら、AICU.jpのコミュニティでお聞かせいただければ幸いです。

https://www.aicu.jp/x/free/discussion/d02d1561-b611-4234-9e78-9b53c3dbb582

モデルのインストールもご意見募集中です。

どんどん成長するサービスになっています!

近日発売予定の書籍の中にもそのような知見を共有していきたいですね。

みなさまのComfyUIの知見をお寄せください!