ComfyUIでLTXVideoを使う方法

動画生成AIのhow to記事です。

今回は昨日リリースされたばかりのLTXVideoを、ComfyUIで使う方法についてご紹介します。

■プロフィール

自サークル「AI愛create」でAIコンテンツの販売・生成をしています。

クラウドソーシングなどで個人や他サークル様からの生成依頼を多数受注。

実際に生成した画像や経験したお仕事から有益となる情報を発信しています。

詳細はこちら(🔞コンテンツが含まれます)

➡️lit.link

※作れる動画サンプル

LTX-Videoは普通に動いた

— AI愛create (@aiaicreate) November 23, 2024

導入少し手間取ったけど生成がビックリするくらい早い

すごいhttps://t.co/jnnYDExRVr pic.twitter.com/A890BFfN6t

i2iも動いた

— AI愛create (@aiaicreate) November 23, 2024

長さは5秒くらいが限界なのかな #LTXVideo

借りた画像:https://t.co/yP9SQ4CNAB pic.twitter.com/yj9KQHTAEd

※github

※動作環境

RTX4060Ti(VRAM16GB)で動かしています。

ネット情報だと3060(12GB)でも十分動くようで、5秒くらいが限度ですが生成は数分程度です。

またComfyUI、ComfyUI-Managerを事前にインストールしている方を対象にしています。

インストールしていない方はこちらの記事を参考にしてください。

LTXVideoのインストール

ComfyUI-Managerをインストールしている方は、Manager→Custom Nodes Manager→LTXVideoを検索してインストールできます。

手動の場合は、どこでもいいのでターミナルを開いてください。

※右クリック→ターミナルで開く

以下のコードでカスタムノードのパスに移動します。

Cドライブ以外にComfyUIをインストールしている方はパスを修正してください。

cd C:\ComfyUI_windows_portable\ComfyUI\custom_nodesLTXVideoをクローンします。

git clone https://github.com/Lightricks/ComfyUI-LTXVideo.gitComfyUI-LTXVideoフォルダに移動して依存関係をインストールします。

githubのコードだと&&になっていますが、powershellの場合は「;」を使います。

cd ComfyUI-LTXVideo; pip install -r requirements.txtモデルのダウンロード

以下のリンクからモデル「ltx-video-2b-v0.9.safetensors」をダウンロードしてください。

データは以下のパスに置きます。

C:\ComfyUI_windows_portable\ComfyUI\models\checkpoints次にtext encoderをダウンロードします。

githubだとリポジトリをクローンする手順が書かれていますが、

「model-00001-of-00002.safetensors」「model-00002-of-00002.safetensors」どちらかのファイルがあれば動かせるようです。

データは以下のパスに置きます。

C:\ComfyUI_windows_portable\ComfyUI\models\text_encodersComfyUI-VideoHelperSuiteのインストール

LTXVideoとは別にVideoHelperSuiteも必要です。

こちらもManager→Custom Nodes Manager→VideoHelperSuiteを検索してインストールできます。

手動の場合はカスタムノードに直接クローンしてください。

※フォルダ移動

cd C:\ComfyUI_windows_portable\ComfyUI\custom_nodes※クローン

git clone https://github.com/Kosinkadink/ComfyUI-VideoHelperSuite.gitComfyUIのアップデート

workflowを取り込んだときにノードが赤く表示され使えないという報告が上がっています。

私も同じ状況だったのですが、ComfyUI本体やカスタムノードの依存関係などをアップデートしたら普通にworkflowが使えました。

Managerを開いてUpdate Allを実行するだけです。

updateフォルダにある「update_comfyui_and_python_dependencies.bat」でもアップデート可能ですが、こっちだとカスタムノードが更新されません。

Managerのアップデートの方が包括できるので簡単だと思います。

※モデルデータをシンボリックリンクで共有している方は、ComfyUI本体をアップデートすると削除されてしまう可能性があるので注意してください。

LTXVideoの使い方

t2v

workflowはこちらです。

・カスタムノードのjson

workflowはどちらもほぼ同じです。

公式からは画像をComfyUIにD&D、カスタムノードからはjsonファイルをダウンロードしてそれをComfyUIにD&Dしてください。

LTXV Loaderは「ltx-video-2b-v0.9.safetensors」を指定します。

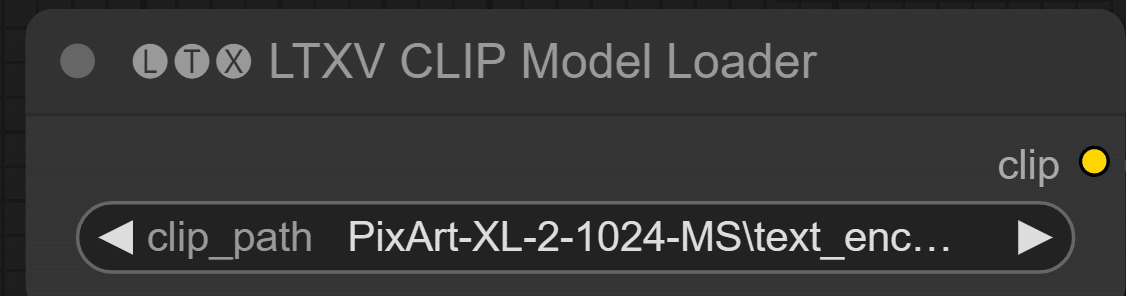

LTXV CLIP Model Loaderは「model-00001-of-00002.safetensors」「model-00002-of-00002.safetensors」どちらかを指定します。

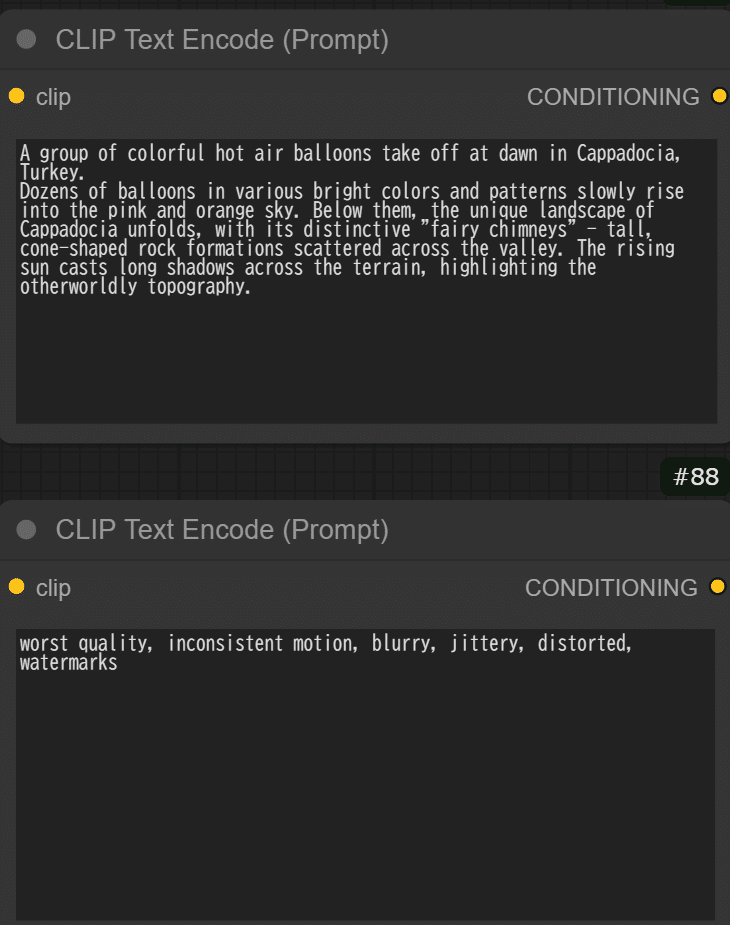

上に生成したいもの、下に生成したくないプロンプトを入力します。

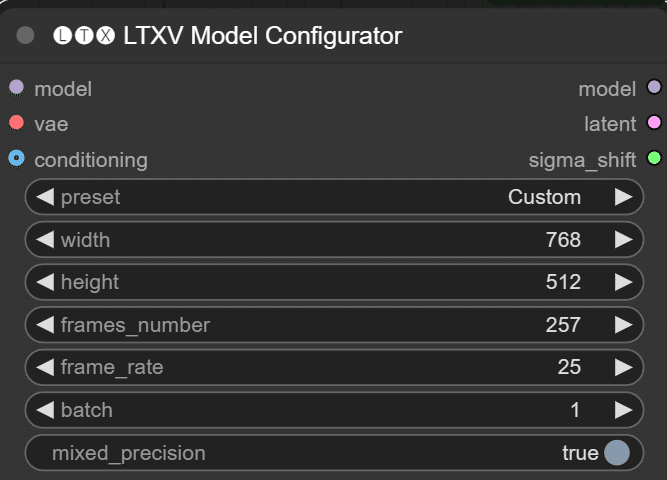

動画の長さを変えたい場合はLTXV Model Configuratorのframes_numberを変えてください。MAX257?のようです。

frame rateを変えると動画の滑らかさを調整できます。

デフォルトの設定で実行すると最初に紹介した気球が飛んでいる動画が生成できます。

LTX-Videoは普通に動いた

— AI愛create (@aiaicreate) November 23, 2024

導入少し手間取ったけど生成がビックリするくらい早い

すごいhttps://t.co/jnnYDExRVr pic.twitter.com/A890BFfN6t

i2v

workflowはこちらです。

・ComfyUI公式

・カスタムノード

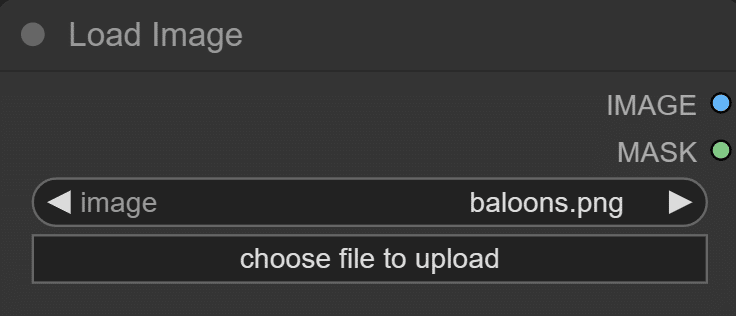

画像をセットする以外はt2vと同じです。画像はLoad Imageから選択、またはD&Dでセットできます。

v2v

v2vはプロンプトを変えて実行してもフレームレート以外の変化がわかりませんでした。

カスタムノードのリポジトリからworkflowがダウンロードできます。

気球の動画もサンプルもあります。

後はworkflowを取り込み、動画をセットして実行するだけです。

以上ComfyUIでLTXVideoを使う方法について、解説しました。

当サークルではこのようなAIに関するさまざまな情報を発信しています。

メンバーシップに加入して頂くと一部の有料記事は読み放題です。

AI技術の向上、マネタイズ方法などに興味がある方は、ぜひご検討ください。

もしこの記事が少しでも役に立った場合は、いいねやフォローして頂けると励みになります。

最後まで読んでいただき、ありがとうございました。

いいなと思ったら応援しよう!