【AI】ローカルでcogstudioを使った動画生成方法

動画生成のhow to記事です。

今回はcogvideoをローカルで動かせるcogstudioの使い方についてご紹介します。

■プロフィール

自サークル「AI愛create」でAIコンテンツの販売・生成をしています。

クラウドソーシングなどで個人や他サークル様からの生成依頼を多数受注。

実際に生成した画像や経験したお仕事から有益となる情報を発信しています。

詳細はこちら(🔞コンテンツが含まれます)

➡️lit.link

メンバーシップ(月額500円)に加入して頂くと、メンバー限定記事と300円以下の有料記事は読み放題です。

cogvideoとは?

txtやimgから動画を生成できるツールです。

過去にsvdやAnimateDiffなど動画を生成できるものはありましたが、cogvideoは動画のクオリティが高く、RTX3060などのグラボでも動かせることもあり、高い評価を得ています。

※VRAM10GBあれば動くようです。

cogstudioのインストール

cogvideoをWebUIで使えるようにしたcogstudioというものがあるので、今回はそちらを利用します。

インストール方法は2種類です。

ワンクリックインストーラーを使う

手動インストールする

ワンクリックインストーラーは他のツールなども簡単にインストールできるpinokioというブラウザを使用します。

StabilityMatrixのような操作感でインストールできるので、コマンド操作が苦手な方におすすめです。

手動インストールはコマンド操作できる方、cogstudioのみ使い方におすすめです。

おそらく余計なものをインストールせずに済むので、手動インストールの方が容量は圧迫せずに済みます。

ワンクリックインストーラーを使う

まず以下のリンクに飛び、Downloadボタンをクリックしてください。

OS毎にインストーラーを提供しているので、「 Download for Windows」からzipをダウンロードします。

任意の場所に解凍して、中にあるexeファイルを実行してください。

以下の画面が表示され、インストール場所とブラウザの外観(light/dark)を選べます。

パスと色を選んだらsaveをクリックしてください。

しばらくするとwelcomeと表示されるので、「Visit Discover Page」をクリックします。

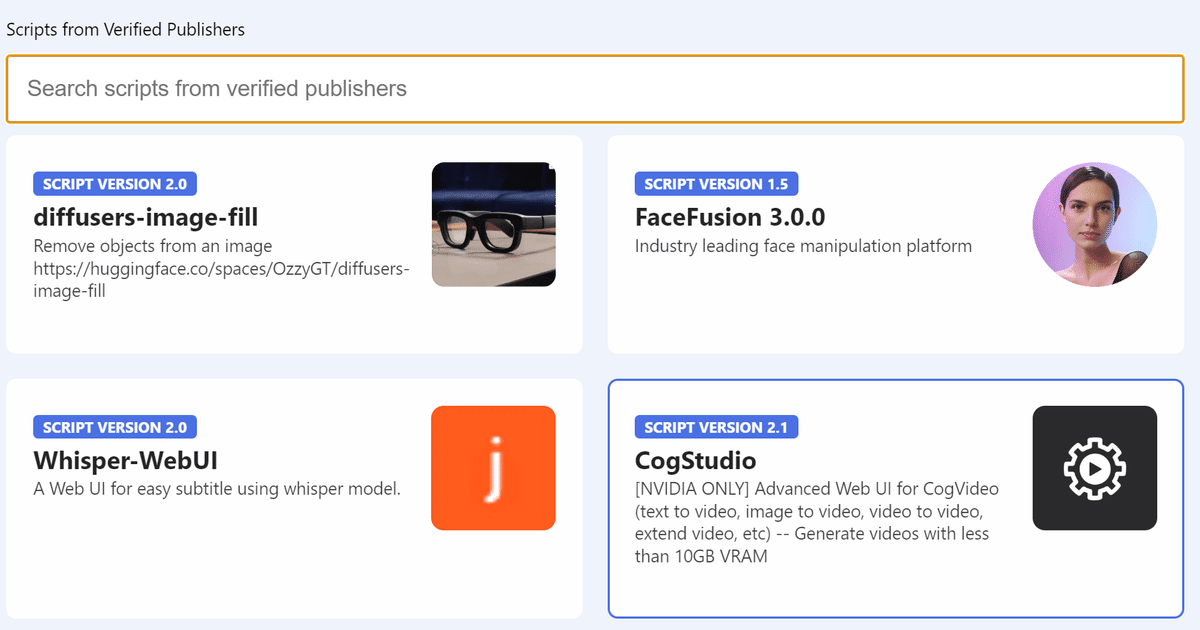

使用できるツール一覧が表示されるので、Cogstudioをクリックしてください。

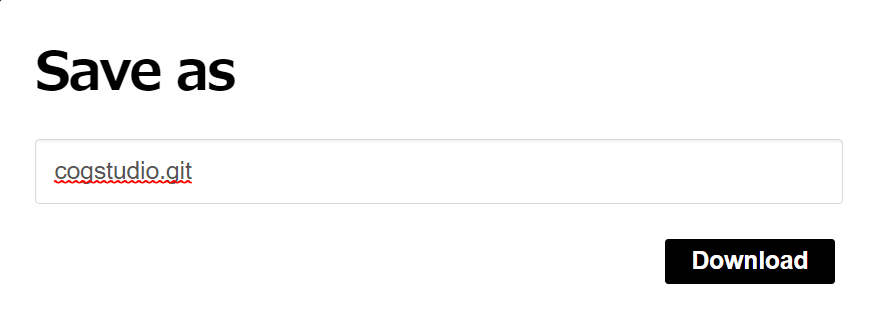

Downloadボタンをクリックします。

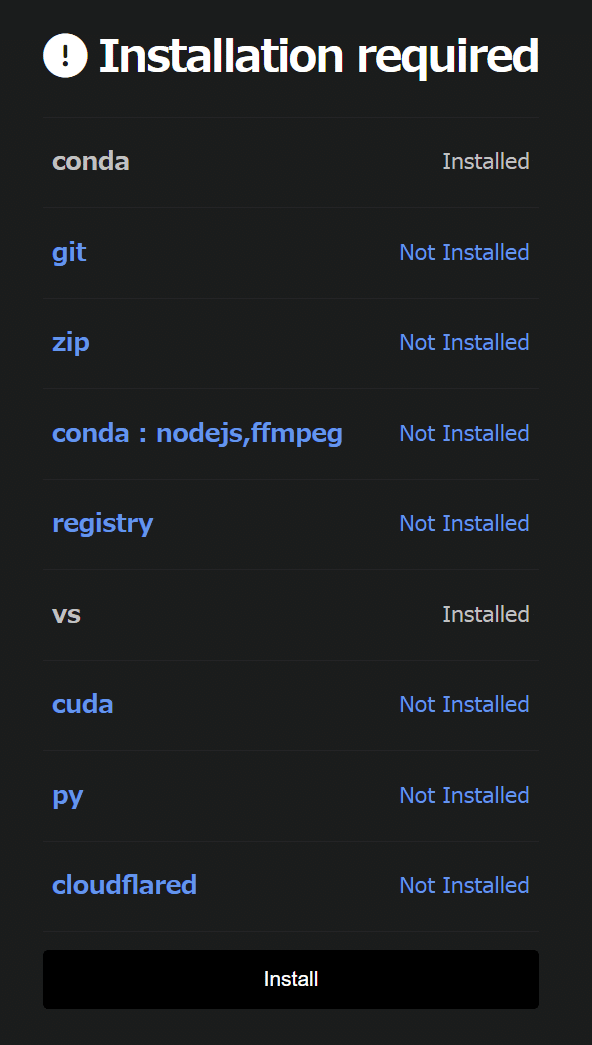

依存関係をインストールしているかどうかが表示されます。

一番下のinstallでインストール可能です。

なお、私の環境だとconda,git,cuda,py,ffmpegなどは既にインストール済みですが、Not Installedになっていました。

※condaはこのツールで途中までインストールしたもの

vsだけ認識されているのがちょっと謎ですが、pinokio経由の場合はpinokio用に別途インストールする必要があるようです。

一通りインストールが終わると以下のような画面が表示されます。Downloadボタンをクリックしてください。

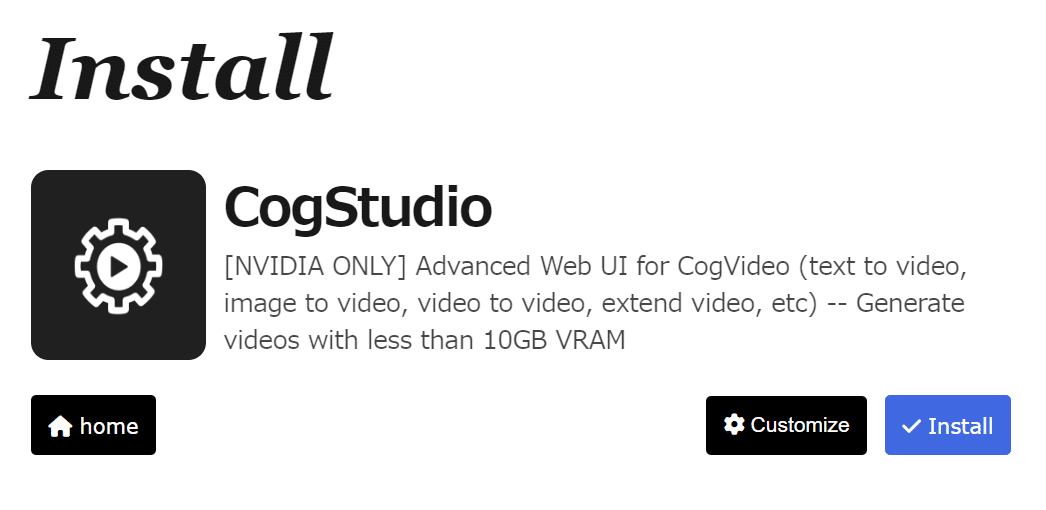

次にCogStudioのインストール画面が表示されます。Installをクリックしてください。

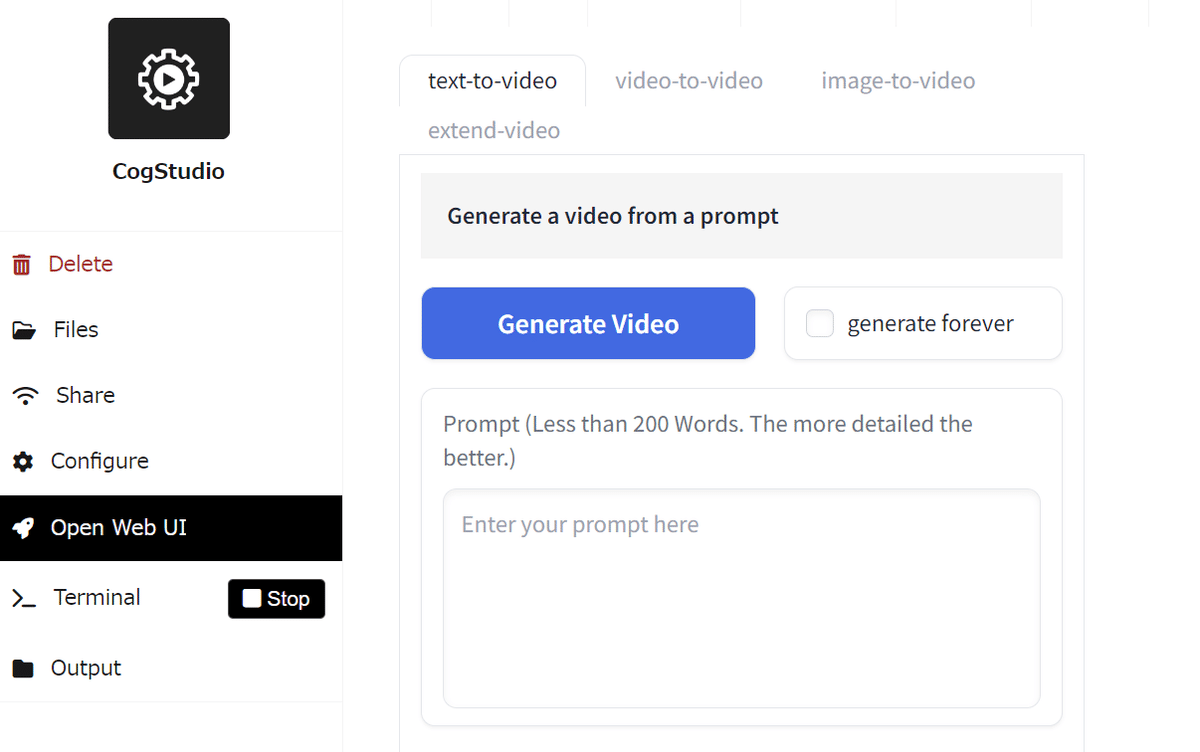

インストールが終わると自動でブラウザが開きます。

これでインストールは完了です。

終了する場合は左メニュー「terminal」のSTOPを押せば止まります。

また2回目以降起動する場合は、「Pinokio Setup 2.15.1.exe」で再度pinokioブラウザを開き、CogStudioをクリックすれば起動できます。

手動インストールする

どこでも良いので右クリック→ターミナルを開くでターミナルを開いてください。

今回はCドライブにインストール方法で解説します。

まずは以下のコードでCドライブに移動してください。

cd C:\次にCogVideoをクローンします。

git clone https://github.com/THUDM/CogVideo以下のリンクから「cogstudio.py」をダウンロードしてください。

右上の矢印からダウンロード可能です。

https://github.com/pinokiofactory/cogstudio/blob/main/cogstudio.py

ダウンロードしたファイルは以下のパスに置きます。

C:\CogVideo\inference\gradio_composite_demogradio_composite_demoフォルダに移動し、仮想環境を作成します。

cd CogVideo/inference/gradio_composite_demo

python -m venv env仮想環境をアクティベートします。

env\Scripts\activate依存関係をインストールします。

pip install -r requirements.txtCUDA用のpytorchをインストールします。

pip install torch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 --index-url https://download.pytorch.org/whl/cu121moviepyをアップグレードします。

pip install moviepy==2.0.0.dev2以下のコードで起動できます。

python cogstudio.pyターミナルにURLが表示されるので、Ctrl+右クリックでUIが開きます。

これでインストールは完了です。

2回目以降起動する場合は、再度仮想環境をアクティベートして、「python cogstudio.py」を実行します。

batファイルを作っておくと楽です。

以下をテキストに保存して拡張子を.batにすれば使えます。

例)start_cogstudio.bat

※Cドライブ以外にインストールした方はパスを書き換えてください。

@echo off

cd /d C:\CogVideo\inference\gradio_composite_demo

call env\Scripts\activate

python cogstudio.pycogstudioの使い方

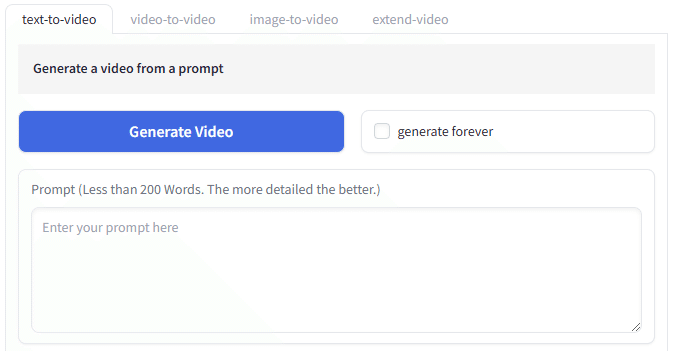

cogstudioは主に4つの使用方法があります。

Text to Video:テキストから動画生成

Video to Video:動画から動画生成

Image to Video:画像から動画生成

Extend Video:動画を拡張

Text to Video

プロンプトを入力して動画を生成できるものです。

試しに以下のプロンプトを入力してみます。

"A cat walking through the house"

使用するModelを選択します。

基本-5bの方がクオリティは高いようです。

Inference Stepsは生成ステップ、Guidance Scaleはどの程度プロンプトに従うかだと思われます。

ここはよくわからなかったので、デフォルトにしました。

dtypeについては2Bを使う場合はfloat16、5bを使う場合はbfloat16が推奨されています。

seed値はランダム性を制御できるものです。同じ動画を生成したい場合などに使うため今回はそのまま。

Super-Resolutionは解像度を拡大できるものです。こちらも処理が重くなりそうなので今回は使用しませんでした。

Don't use CPU offloadはVRAM消費量が多いときにチェックを入れると生成が速くなるそうです。

設定したら上にある「Generate Video」を押すと生成が始まります。

generate foreverは連続生成できるオプションです。

※初回生成時に約10GBほどのモデルがダウンロードされます。

・結果

t2vにしてはかなりクオリティが高く感じました。

脚が途切れている部分もありますが、比較的綺麗に再現できていると思います。

処理も5分程度だったので、t2vで簡単に動画生成したい方にはいいかもしれません。

video to video

既存の動画を取り込み、プロンプトで変化を与えて動画を生成できます。

video to videoのタブで操作できます。

まずはD&D、または選択して動画を取り込みます。

今回こちらの動画をお借りしました。

https://www.pexels.com/ja-jp/video/855976/

プロンプトでどういう動画にしたいか入力します。

今回は「anime sytle, black flower」と入力してみました。

パラメータはデフォルトのままです。

・結果

video to videoについてはそこまで大きな変化は与えられませんでした。

モデルやパラメータを変えて何度か試してみたのですが、変化は微々たるもの。

生成時間はt2vとほぼ変わりませんでした。

githubのサンプルでもあまり大きな違いはなかったので、video to videoをコントロールするのは難しいかもしれません。

strengthやプロンプトの入力方法によってはもう少しうまく調整できる可能性もあります。

image-to-video

画像から動画を生成できるものです。

image-to-videoタブで操作できます。

使い方はvideo to videoとほぼ同じです。

モデルはi2v専用のものを使用するため、選択項目はありません。

まずは動画化したい画像を取り込んでください。

次に変化を与えたいプロンプトを入力します。

例)Walking slowly.

あとはパラメータを調整してGenerate Videoで生成できます。

・2次元の結果

・3次元の結果

まず2次元画像は顔が維持できず、完全にホラーでした。

画像が悪いだけかもしれないので、別の画像なら綺麗に生成できるかもしれません。

3次元は二次元ほど崩れることはなく、「歩く」もある程度は再現できていると思います。

処理についてはtxtやvidに比べて長く、20分くらいかかりました。

元動画の解像度やサイズを変えても同じだったので、img2vidはモデルが違うこともあり、処理に時間がかかるのかもしれません。

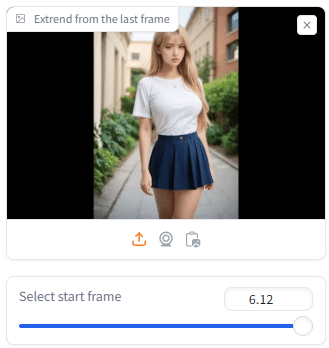

extend video

extend videoは動画の長さを伸ばせる機能です。

今回はimege to videoで生成した動画を伸ばしてみます。

なお生成した動画は一番下のボタンで別タブに送ることができます。

最初にSelect start frameを指定します。

これはどのフレームを元に動画を生成するか指定するものです。

画像を見ながらスライダーで選択できます。

次にプロンプトを入力します。image-to-videoと同じ「Walking slowly.」と入力しました。

これでGenerate Videoをクリックすれば処理が始まります。

・結果

拡張自体はできていますが、拡張部分の6秒以降から急にスイッチが入ったような動きになりました。

そこまでひどい崩れなどはありませんが、実用的ではないかもしれません。

処理についてはimg2vidと同じく20分くらいかかりました。

基本的な使い方は以上です。

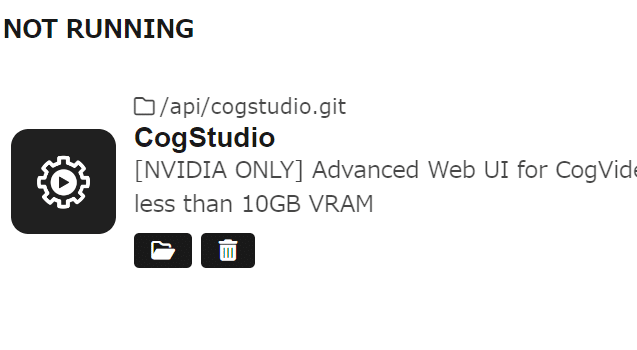

cogstudioのアンインストール

ワンクリックインストーラーでインストールし、cogstudioのみアンインストールしたい場合は、pinokioを起動して、ごみ箱アイコンからアンインストールできます。

pinokioごと削除したい方は、pinokioフォルダを削除してください。

手動インストールした場合は「CogVideo」フォルダを削除すればいいだけです。

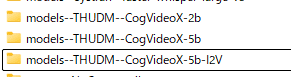

モデルに関しては2b・5b・5b-I2Vの3種類が以下のパスに保存されます。

保存されるのは使用したものだけです。

こちらを削除すればモデルも削除できます。

C:\Users\ユーザー名.cache\huggingface\hub参考:https://github.com/pinokiofactory/cogstudio

cogstudioを使ってみた感想

txt2vidが一番クオリティが高いように感じました。

オープンソースという点を考えるとimg2vidも悪くはないのですが、klingやrunwayなど有料サービスに比べるとやはり劣ってしまうかもしれません。

あとは解像度を上げるオプションを使ってどの程度クオリティが変わるのかという感じです。

まだ使いこなせてない部分もあるので、何らかの発見があったら追記します。

以上cogstudioの使用方法についてご紹介しました。

当サークルではこのようなAIに関するさまざまな情報を発信しています。

メンバーシップに加入して頂くと一部の有料記事は読み放題です。

AI技術の向上、マネタイズ方法などに興味がある方は、ぜひご検討ください。

もしこの記事が少しでも役に立った場合は、いいねやフォローして頂けると励みになります。

最後まで読んでいただき、ありがとうございました。

いいなと思ったら応援しよう!