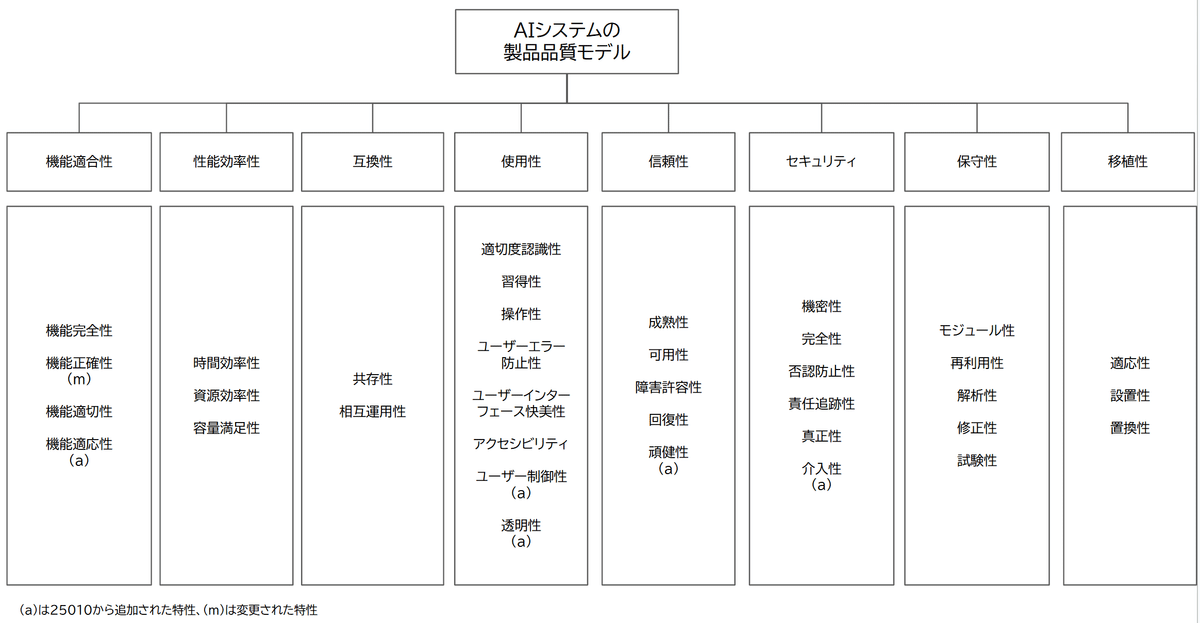

AIシステムの製品品質モデル ISO/IEC25059:2023

生成AI(LLM)アプリケーションのテストを考えるにあたって、ISO/IEC 25000シリーズで提唱されている、AIシステムの製品品質モデル、ISO/IEC 25059:2023 Systems and software Quality Requirements and Evaluation (SQuaRE) — Quality model for AI systems のうち、25010から追加、変更された特性に焦点をあてて解説します。

なお、本記事は標準に基づいて筆者の理解を記述しています。正確な定義、計測方法については、標準をご確認ください。

ISO/IEC 25059:2023 AI system product quality

出典: ISO/IEC 25059:2023, https://www.iso.org/obp/ui/en/#iso:std:iso-iec:25059:ed-1:v1:en

ISO/IEC25059:2023の全体像を、筆者による日本語訳で示します。品質特性の日本語訳はさまざまな文献で揺れます。翻訳の決定版には、JIS:Xでの登場が待たれるところです。

機能正確性(functional correctness)

degree to which a product or system provides the correct results with the needed degree of precision

Note 1 to entry: AI systems, and particularly those using machine learning models, do not usually provide functional correctness in all observed circumstances.

製品またはシステムが、要求される精度の範囲内で正しい結果を提供する度合い 注記: AIシステム、特に機械学習モデルを使用するシステムは、すべての観測された状況において機能的正確性を確保できるとは限りません。

※なお、定義の後に続く日本語訳はすべて筆者によるものです。

25010 における機能正確性は、システムが正確な応答を返す度合いを指しており、正しい応答は常に一意に決まり、その応答がどれぐらいの精度で得られるか、を問うものでしたが、25059では、システムの応答は常に一意に定まらないことを前提として「要求される精度の範囲内」において、正しい応答を返す度合い、と定義が変更されています。

機能適応性(functional adaptability)

degree to which an AI system can accurately acquire information from data, or the result of previous actions, and use that information in future predictions

AIシステムがデータや過去の行動の結果から正確に情報を取得し、その情報を将来の予測に活用できる度合い。

「過去の行動の結果から情報を取得する」とは、例えば生成AIチャットアプリケーションにおいては、セッションコンテクスト(これまでの会話の流れを踏まえて回答を生成する) や、RAG等を活用して外部データを適切に取得・統合し、その情報を将来の応答に活用できる度合い などを指すものと思われます。

ユーザー制御性(user controllability)

degree to which a user can appropriately intervene in an AI system’s functioning in a timely manner

AIシステムの動作に対して、ユーザーが適切なタイミングで介入し、制御できる度合い。

「ユーザーが適切に介入する」とは、例えば生成AIチャットアプリにおいて、ユーザーがプロンプトや出力を調整できる機能、AIの推奨結果に対するオーバーライド機能、応答スタイルや振る舞いのカスタマイズ設定 などを指すものと考えられます。これにより、ユーザーがAIの動作を適切に制御し、望ましい結果を得ることが可能になります。

透明性(transparency)

degree to which appropriate information about the AI system is communicated to relevant stakeholders

Note 1 to entry: Appropriate information for AI system transparency can include aspects such as features, components, procedures, measures, design goals, design choices and assumptions.

AIシステムに関する適切な情報が、関係するステークホルダーに対して伝達される度合い。

注記 1: AIシステムの透明性に関する適切な情報には、機能、構成要素、手順、測定方法、設計目標、設計上の選択肢、および前提条件などの側面が含まれる場合があります。

透明性とは、生成AIがどのデータを基に学習し、どのようなアルゴリズムで推論を行っているのか、その結果に影響を与えるバイアスや制約があるかどうかを明示できる度合いを指します。また、AIがなぜ特定の判断を下したのかを説明できる「説明可能性(explainability)」も透明性の一要素です。

透明性が確保されることで、ユーザーはAIの動作を理解しやすくなり、誤用を防ぎ、信頼性を向上させることができます。特に、AIの意思決定が人間に影響を与える場合(医療、金融、採用など)、透明性は倫理的・法的な観点からも重要な要素となります。

頑健性(robustness)

degree to which an AI system can maintain its level of functional correctness under any circumstances

AIシステムが、いかなる状況においても機能的正確性の水準を維持できる度合い。

"circumstances" はあまり馴染みのなかった単語なのですが、"situation" とセットで説明され、どちらも訳は「状況」ですが、前者の方がより細かい事実といった意味合いだそうです。AIシステムにおいては、MLOpsの1サイクルの結果というよりは、ユーザの入力といったより細かい状況に対する特性と考えるとしっくりきます。

頑健性(robustness) を既存するユーザーの操作や攻撃には、主に 意図的な攻撃(adversarial attacks) と 非意図的な誤用(unintentional misuse) の2つのカテゴリがあります。前者にはプロンプトインジェクションやデータポイズニング、敵対的サンプル攻撃などがあり、後者には不適切な入力(タイプミスなど)、バイアスの強化(意図的でないにせよ)などがあります。

介入性(intervenability)

degree to which an operator can intervene in an AI system’s functioning in a timely manner to prevent harm or hazard

AIシステムの動作に対して、オペレーターが適切なタイミングで介入し、危害やリスクを防ぐことができる度合い。

「ユーザー制御性(user controllability)」 と 「介入性(intervenability)」 は、どちらもAIシステムへの人間の関与に関する品質特性ですが、対象者と目的が異なります。

ユーザー制御性 = 「ユーザーが、AIの動作をカスタマイズ・調整できる自由度」

介入性 = 「システムの管理者が、AIが問題を起こしたとき、すぐに介入できる能力」

介入性は後者の能力によって、AIシステムが致命的な応答や操作を行ってしまうことを防げる度合い、を指します。

ISO/IEC 25059:2023 Quality in use

25010と同様に、25059ではシステム製品の品質モデルに加えて、利用時の品質モデルも定義されています。主特性については、25010と同様に、「有効性」、「効率性」、「満足性」、「リスク回避性」、「利用状況網羅性」の5つから構成されており、そのうち、満足性の子要素としての「透明性」、リスク回避性の子要素として「社会的・倫理的リスクの低減性(societal and ethical risk mitigation)」が新たに追加されています。

「透明性」については、定義自体は AI system product quality と同様と目されますが、それがユーザの利用シーンにおいてどのように有効に働くのかの度合い、であることが推定されます。

社会的・倫理的リスクの低減性(societal and ethical risk mitigation)

societal and ethical risk mitigation degree to which an AI system mitigates potential risk to society

Note 1 to entry: Societal and ethical risk mitigation includes accountability, fairness, transparency and explainability, professional responsibility, promotion of human value, privacy, human control of technology, community involvement and development, respect for the rule of law, respect for international norms of behaviour and labour practices.

AIシステムが社会に及ぼす潜在的なリスクをどの程度軽減できるかを示す度合い。

注記 1: 社会的・倫理的リスクの低減には、説明責任、公正性、透明性と説明可能性、専門的責任、人間の価値の促進、プライバシー、技術に対する人間の制御、コミュニティの関与と発展、法の支配の尊重、国際的な行動規範の尊重、および適切な労働慣行 などが含まれます。

注記1にもあるように、非常に広範な分野をカバーする特性です。広範すぎるので、これ自体を主特性として、注記に並んでいる要素を副特性としてもよいレベルのように感じました。また、若干センシティブではありますが、ISOが属するいわゆる西側諸国の論理も多少含まれているように感じます。

注記はあくまで注記であるので、システムが主に利用される国の状況における「社会的・倫理的」なリスクの識別自体から行うのが良さそうです。