note 263日目 MGSスクレイピング

昨日のnoteでは今日の作業の目標をこんな感じで立ててました。

明日(10/15)の目標:

・10記事投稿(サイトB)

・カスタム投稿の習得(サイトA)

・MGS100作品の作品選定(なんとなくは既に決めてます)

結果は、、、、

・記事はたったの3記事。

・カスタム投稿の習得に費やす時間はゼロ…

・MGS100作品の選定は後回し(やっていない)

です。情けない…

手作業で3記事投稿したのですが、やっぱり効率悪いことを感じてしまい、MGSのサイトからスクレイピングできないか考え始めてしまいました…

ちなみにMGSは6月にスクレイピングをトライしましたが断念してます。

前回はGASでしたが、今回はChrome機能のWeb Scraperでスクレイピングしてみることにしました。

Web Scraperは久しぶりでしたので忘れてしまっていることも多々あります。

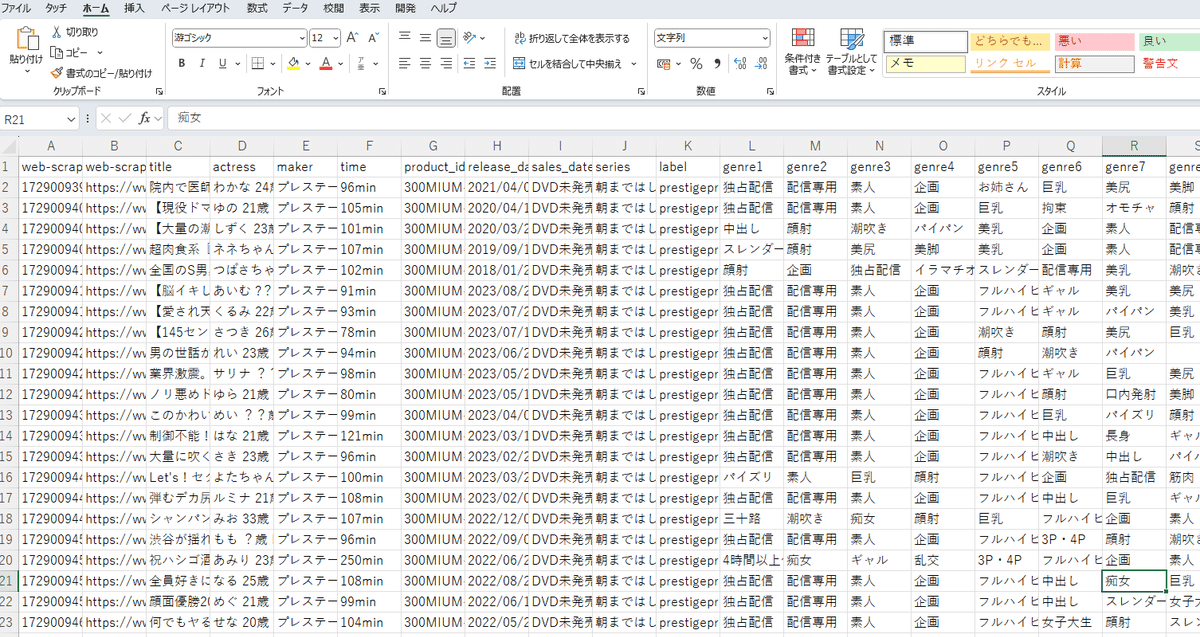

とりあえずどんな感じになるのかスクレイピングでデータ取得。

その後、MGS用にWeb Scraperをカスタマイズしてみました。

今まで知らなかった使い方などもあったので、新しい発見もありました。

あるシリーズの作品が120作品ほどありましたが数分で取得できました。

やはり便利…

本日の作業はここまで。

とりあえずこのやり方でやってみます。

・作品データはスクレイピングで取得。

・記事はChatGPT作成。

この2種類のデータをCSVにしてカスタムフィールドで投稿するフローにします。今までとあまり変わりませんね…

■ 明日以降の作業目標:

・カスタムフィールドの登録

・single.phpのコード作成

・GAS関数作成(アフィリエイトリンク・サンプル動画)

・ChatGPT活用の記事作成のルール化(文字数・サイト構成)

・カスタム投稿の習得

手作業でやってみた結果、やはり効率の良いこと(自動化)をやってしまいます。まあ、手作業といっても頭は使わず作業しているといった感じです。

その手間のかかる作業をGASやChatGPTでやってしまうということです。

ただ、手作業をしないとこの効率化(自動化)を考える発想が出てこないので、手作業(手動作成)は非常に重要です。