初心者から上級者まで:Webデータ抽出ツールのおすすめ 5選

1.Beautiful Soup

Beautiful SoupはPythonで書かれたライブラリで、HTMLやXML文書の解析を簡単に行うことができます。主にWebスクレイピングのために使用され、ウェブページの構造を理解し、必要な情報を抽出するのに役立ちます。Beautiful Soupは、タグの検索やデータの取得を直感的に行えるAPIを提供しており、特にWebデザインの知識があまりないユーザーにも優しい設計になっています。

特徴:

・柔軟なHTML/XMLの解析。

・スクリプトを簡潔に記述でき、初心者にも扱いやすい。

・他のPythonライブラリ(Requestsなど)との組み合わせが可能。

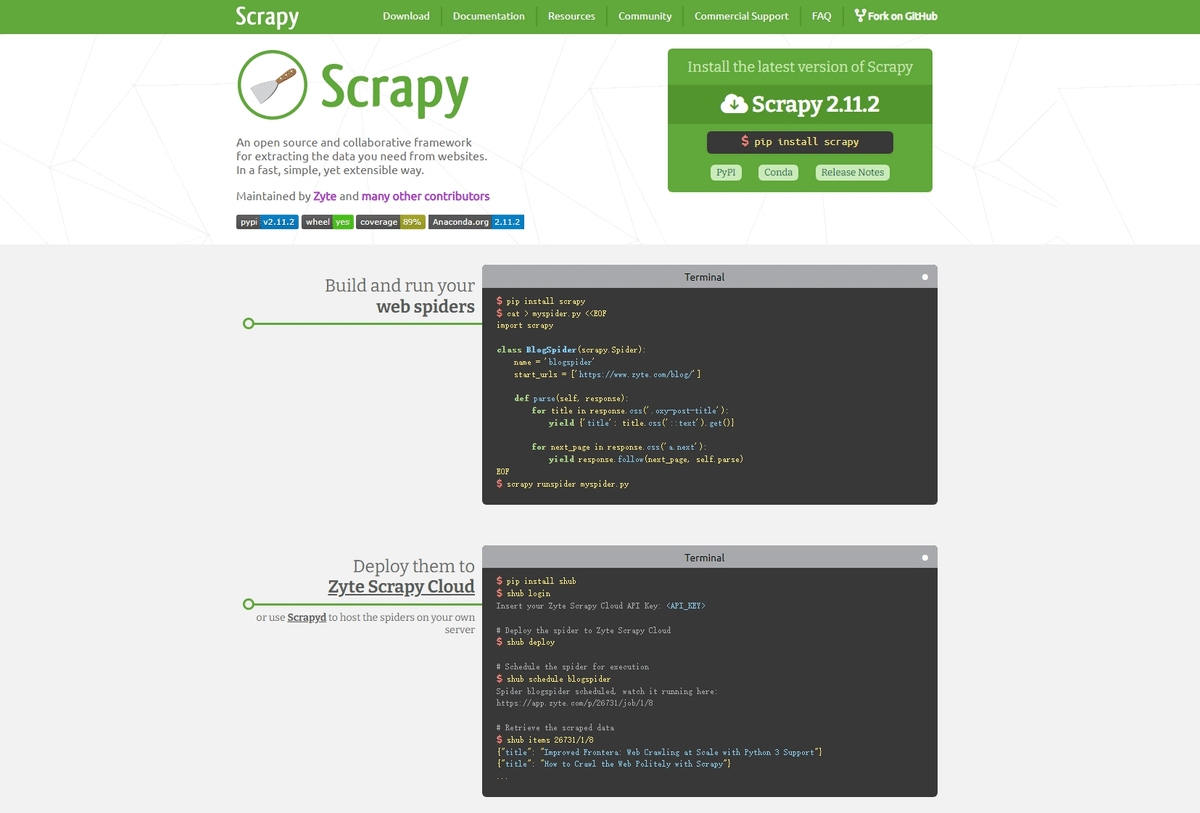

2.Scrapy

Scrapyは、Pythonのフレームワークで、大規模なWebスクレイピングプロジェクトを効率的に管理するために設計されています。Scrapyは、サイトをクロールし、データを自動的に収集するための機能を備えています。非同期処理を活用しているため、複数のページを同時に処理でき、全体のデータ取得が迅速です。また、強力なデータパイプラインを持ち、抽出したデータをさまざまなフォーマット(JSON、CSV、XMLなど)で保存できます。

特徴:

・クロールとデータ抽出を一体化。

・非同期処理を利用した高速なデータ取得。

・自動的なデータ保存(CSV、JSONなど)が可能。

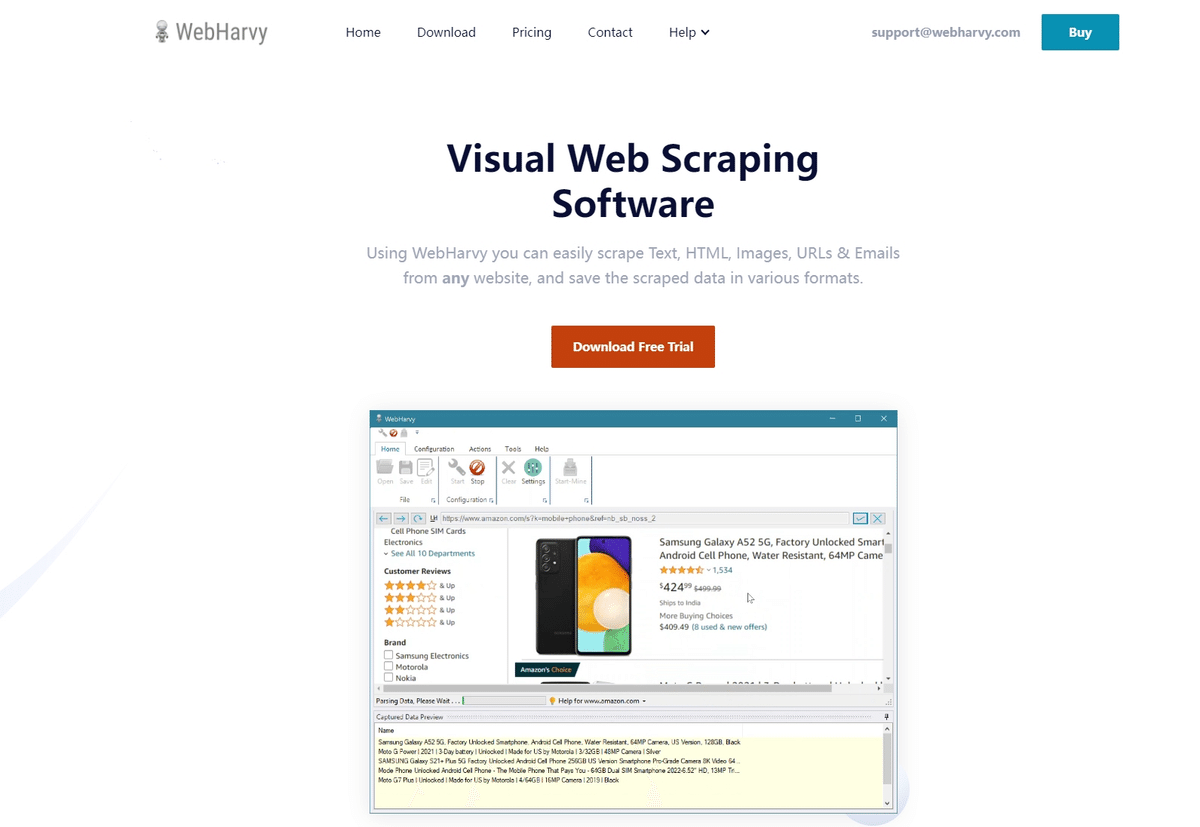

3.WebHarvy

WebHarvyは、コードを使用せずにデータを抽出できる視覚的なWebスクレイピングツールです。ユーザーインターフェースが直感的で、ポイント&クリックで必要なデータを選択することができます。このツールは特に、初心者やプログラミングの知識がないユーザーに適しており、簡単にスクレイピングを始められます。WebHarvyは、定期的なデータ収集をスケジュールする機能や、データのエクスポート機能も備えています。

特徴:

・簡単なクリック操作でデータを抽出。

・スケジュール機能があり、定期的なデータ取得が可能。

・動的なコンテンツのスクレイピングにも対応。

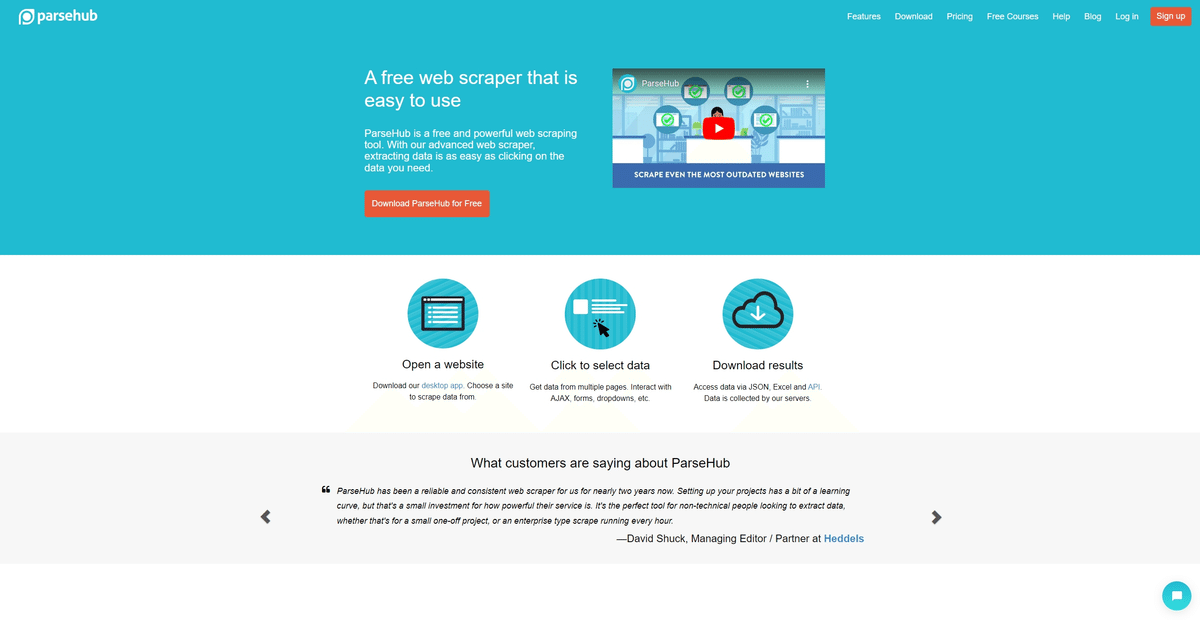

4.ParseHub

ParseHubは、視覚的に操作できるWebスクレイピングツールで、ユーザーはコードを書かずにデータを抽出することができます。ポイント&クリックインターフェースを使用して、必要なデータを選択し、複雑なウェブページでも容易に操作できます。さらに、ParseHubは、JavaScriptで生成された動的なコンテンツにも対応しており、非常に柔軟性があります。また、データをAPIを通じて取得できるため、他のアプリケーションとの連携もスムーズです。

特徴:

・ポイント&クリックでデータを抽出。

・複雑なサイトや動的なコンテンツにも対応。

・APIを介してデータを取得し、外部システムと統合できる。

5.Diffbot

Diffbotは、AIを用いたWebデータ抽出サービスで、ウェブページの内容を自動的に分析し、構造化データに変換します。このツールは、RESTful APIを介して利用できるため、開発者がプログラムから簡単にアクセスしてデータを取得することができます。Diffbotは、ニュース、製品、Wikiページなどの多様なデータタイプを処理でき、特にビジネスやリサーチ向けのデータ収集に強みを持っています。

特徴:

・ページ内容を自動的に解析し、特定のデータを抽出。

・RESTful APIを提供し、プログラムからのアクセスが可能。

・ニュース、製品、Wikiなど、さまざまなデータタイプに対応。